Johdanto Hadoop-kehykseen

Ennen kuin syventämme Hadoopin teknisiä kehyksiä, aloitamme yksinkertaisella esimerkillä.

Siellä on maatila, joka korjaa tomaatit ja varastoi niitä yhdellä varastotilalla. Nyt kasvavan vihannesten kysynnän myötä maatila aloitti sadonkorjuun perunoista ja porkkanoista - kasvavan kysynnän vuoksi viljelijöistä oli pulaa, joten he palkkasivat lisää viljelijöitä. Jonkin ajan kuluttua he tajusivat, että varastoalueella oli pulaa - joten he jakoivat vihannekset eri varastoalueille. Tietojen noutamisessa kaikki toimivat samanaikaisesti oman tallennustilansa kanssa.

Joten miten tämä tarina liittyy isoihin tietoihin?

Aikaisemmin meillä oli rajoitettua dataa, rajoitetulla suorittimella ja yhdellä tallennusyksiköllä. Mutta sitten datan sukupolvi kasvoi, mikä johti suuren määrän ja erilaisiin lajikkeisiin - jäsenneltyihin, osittain jäsenneltyihin ja jäsentämättömiin. Joten ratkaisu oli käyttää hajautettua tallennustilaa jokaiselle prosessorille, mikä mahdollisti helpon pääsyn tietojen tallentamiseen ja käyttämiseen.

Joten nyt voimme korvata vihannekset erityyppisillä tietojen ja säilytyspaikoilla kuin hajautetut paikat tietojen tallentamiselle ja eri työntekijät ovat kukin prosessori.

Joten iso data on haaste ja Hadoop on osa ratkaisua.

Hadoop

1. Ratkaisu suuriin tietoihin: koska se käsittelee suuren volyymin, nopeuden ja monenlaisten tietojen monimutkaisuuksia.

2. Sarja avoimen lähdekoodin projektia.

3. Tallentaa valtavan määrän dataa luotettavasti ja sallii valtavat hajautetut laskelmat.

4. Hadoopin tärkeimmät ominaisuudet ovat redundanssi ja luotettavuus (ei mitään tietojen menetystä).

5. Keskitytään pääasiassa eräkäsittelyyn.

6. Toimii hyödykelaitteilla - sinun ei tarvitse ostaa erityisiä kalliita laitteita.

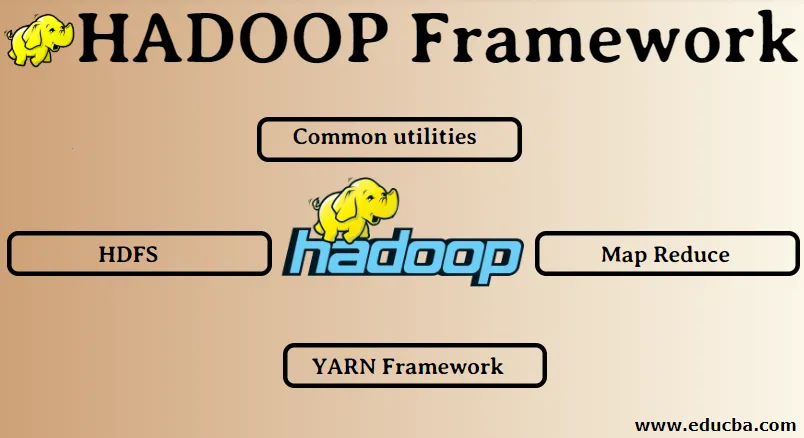

Hadoop-kehys:

1. Yleiset apuohjelmat

2. HDFS

3. Kartta pienennä

4. lanka kehys

1. Yleiset apuohjelmat:

Kutsutaan myös Hadoop yleinen. Nämä ovat vain JAVA-kirjastoja, tiedostoja, skriptejä ja apuohjelmia, joita muiden Hadoop-komponenttien tosiasiallisesti edellytetään suorittavan.

2. HDFS: Hadoop-hajautettu tiedostojärjestelmä

Miksi Hadoop on valinnut sisällyttää hajautettu tiedostojärjestelmä?

Ymmärretään tämä esimerkillä: Meidän on luettava 1 Tt dataa ja meillä on yksi kone, jossa on 4 I / O-kanavaa, jokaisella kanavalla on 100 Mt / s. Koko datan lukeminen kesti 45 minuuttia. Nyt 10 dataa lukee saman määrän dataa, jokaisella on 4 I / O-kanavaa, jokaisella kanavalla on 100 Mt / s. Arvaako tietojen käsittelyyn kulunut aika? 4, 3 minuuttia. HDFS ratkaisee isodatan tallennusongelman. HDFS: n kaksi pääkomponenttia ovat NAME NODE ja DATA NODE. Nimesolmu on isäntä, meillä voi olla myös toissijainen nimissolmu, jos ensisijainen nimisolmu lakkaa toimimasta, toissijainen nimisolmu toimii varmuuskopiona. Nimesolmu ylläpitää ja hallitsee datasolmuja periaatteessa tallentamalla metatietoja. Tietosolmu on orja, joka on pohjimmiltaan edullisten hyödykkeiden laitteisto. Meillä voi olla useita datasolmuja. Tietosolmu tallentaa todellisen datan. Tämä datasolmu tukee replikaatiotekijää. Oletetaan, että jos yksi datasolmu menee alas, niin data toiseen replikoituun datasolmuun pääsee käsiksi, joten datan saavutettavuutta parannetaan ja datan katoaminen estetään.

3. Kartta pienennä:

Se ratkaisee suurten tietojen käsittelyongelman. Ymmärretään kartan käsite vähenee ratkaisemalla tämä reaalimaailman ongelma. ABC-yritys haluaa laskea kokonaismyyntinsä kaupungin kannalta. Nyt tässä hash table -konsepti ei toimi, koska tiedot ovat teratavuina, joten käytämme Map-Reduce -konseptia.

Siinä on kaksi vaihetta: a) MAP. b) Vähennä

a) Kartta : Ensin jaamme tiedot pienempiin paloihin, joita kutsutaan karttaajiksi avain / arvo-parin perusteella. Joten tässä avaimessa on kaupungin nimi ja arvo on kokonaismyynti. Jokainen karttaaja saa kunkin kuukauden tiedot, jotka antavat kaupungin nimen ja vastaavan myynnin.

b) Pienennä: Se saa nämä datapaalut ja kukin vähennysyksikkö vastaa pohjois / länsi / itä / etelä-kaupungeista. Joten pelkistimen työ on kerätä nämä pienet palat ja muuntaa suuremmiksi määriksi (lisäämällä ne yhteen) tiettyyn kaupunkiin.

4.YARN-kehys: Vielä yksi resurssineuvottelija.

Alkuperäisessä Hadoopin versiossa oli vain kaksi komponenttia: Map Reduce ja HDFS. Myöhemmin havaittiin, että Map Reduce ei pystynyt ratkaisemaan monia suuria dataongelmia. Ajatuksena oli viedä resurssienhallinta- ja työsuunnitteluvastuu pois vanhasta kartan pienentämismoottorista ja antaa se uuteen komponenttiin. Joten näin lanka tuli kuvaan. Keskittymä on HDFS: n ja Map Reducen välinen, joka vastaa klusterresurssien hallinnasta.

Sillä on kaksi avainroolia suoritettaviksi: a) Työn aikataulutus. b) Resurssien hallinta

a) Työn aikataulu: Kun suuri määrä tietoa annetaan käsittelyä varten, se on jaettava ja jaoteltava eri tehtäviin / tehtäviin. Nyt YS päättää, mikä työ on annettava etusijalle, kahden työn välinen aikajakso, riippuvuus työpaikkojen välillä, tarkistaa, ettei käynnissä olevissa töissä ole päällekkäisyyksiä.

b) Resurssien hallinta: Tarvitsemmeko resursseja tietojen käsittelemiseen ja tallentamiseen? Joten resurssienhallinta tarjoaa, hallinnoi ja ylläpitää resursseja tietojen tallentamiseksi ja käsittelemiseksi.

Joten nyt olemme selkeitä Hadoopin käsitteestä ja siitä, kuinka se ratkaisee BIG DATA: n luomat haasteet !!!

Suositellut artikkelit

Tämä on opas Hadoop-kehykseen. Täällä olemme keskustelleet myös neljästä parhaasta Hadoop-kehyksestä. Voit myös käydä läpi muiden ehdotettujen artikkeleidemme saadaksesi lisätietoja -

- Hadoop-tietokanta

- Hadoop-ekosysteemi

- Hadoopin käyttö

- Hadoop-järjestelmänvalvojan työpaikat

- Hadoop-järjestelmänvalvoja | Taidot ja urapolku