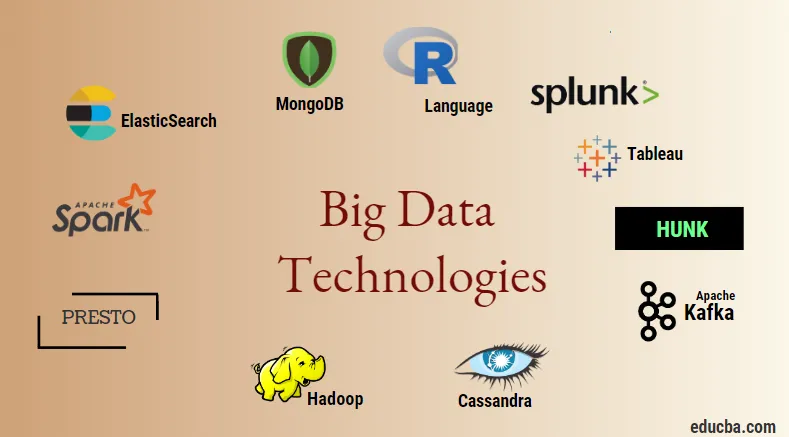

Johdanto Big Data -teknologioihin

Suuri tietotekniikka ja Hadoop on iso buzzword, koska se saattaa kuulostaa. Koska tieto- ja tietoalueet ovat kasvaneet valtavasti kaikilla toimialoilla ja aloilla, on erittäin tärkeää luoda ja ottaa käyttöön tehokas tekniikka, joka huolehtii tietojen tuottamisesta vastaavien asiakkaiden ja suurten teollisuudenalojen kaikista tarpeista ja vaatimuksista. . Aikaisemmin tietoja käsittelivät normaalit ohjelmointikielet ja yksinkertainen jäsennelty kyselykieli, mutta nyt nämä järjestelmät ja työkalut eivät näytä tekevän paljon isojen tietojen tapauksessa. Suurtena tietotekniikkana tarkoitetaan tekniikkaa ja ohjelmistoapuohjelmaa, joka on suunniteltu tietojen analysointiin, käsittelyyn ja poimintaan suuresta joukosta erittäin monimutkaisia rakenteita ja suurista tietokokonaisuuksista, joita perinteisten järjestelmien on vaikea käsitellä. Suuria tietotekniikoita käytetään sekä reaaliaikaisen että eräkohtaisten tietojen käsittelemiseen. Koneoppimisesta on tullut erittäin kriittinen osa jokapäiväistä elämää ja kaikkia toimialoja, ja siksi datan hallinnasta isojen tietojen avulla on erittäin tärkeää.

Big Data -teknologioiden tyypit

Ennen kuin aloitat tekniikkaluettelon kanssa, katsotaan ensin kaikkien näiden tekniikoiden laaja luokitus. Ne voidaan pääasiassa luokitella neljään verkkotunnukseen.

- Tietovarasto

- Analytics

- Tietojen louhinta

- visualisointi

Tarkastellaan ensin kaikkia tekniikoita, jotka kuuluvat varastoinnin sateenvarjoon.

1. Hadoop : Kun kyseessä on iso data, Hadoop on ensimmäinen tekniikka, joka tulee markkinoille. Tämä perustuu karttaa pienentävään arkkitehtuuriin ja auttaa eräajoihin liittyvien töiden ja erätietojen käsittelyssä. Se oli suunniteltu tallentamaan ja käsittelemään tietoja hajautetussa tietojenkäsittely-ympäristössä yhdessä hyödykelaitteiston ja yksinkertaisen ohjelmoinnin suoritusmallin kanssa. Sitä voidaan käyttää erilaisten koneiden sisältämien tietojen tallentamiseen ja analysointiin, joilla on suuri tallennus, nopeus ja alhaiset kustannukset. Tämä on yksi suurimman tietotekniikan pääkomponentista, jonka Apache-ohjelmistoäätiö kehitti vuonna 2011 ja on kirjoitettu Java-kielellä.

1. Hadoop : Kun kyseessä on iso data, Hadoop on ensimmäinen tekniikka, joka tulee markkinoille. Tämä perustuu karttaa pienentävään arkkitehtuuriin ja auttaa eräajoihin liittyvien töiden ja erätietojen käsittelyssä. Se oli suunniteltu tallentamaan ja käsittelemään tietoja hajautetussa tietojenkäsittely-ympäristössä yhdessä hyödykelaitteiston ja yksinkertaisen ohjelmoinnin suoritusmallin kanssa. Sitä voidaan käyttää erilaisten koneiden sisältämien tietojen tallentamiseen ja analysointiin, joilla on suuri tallennus, nopeus ja alhaiset kustannukset. Tämä on yksi suurimman tietotekniikan pääkomponentista, jonka Apache-ohjelmistoäätiö kehitti vuonna 2011 ja on kirjoitettu Java-kielellä.

2. MongoDB : Toinen erittäin tärkeä ja tärkeä osa suurten tietotekniikoiden varastointia on MongoDB NoSQL-tietokanta. Se on NoSQL-tietokanta, mikä tarkoittaa, että relaatiominaisuudet ja muut RDBMS: ään liittyvät ominaisuudet eivät koske sitä. Se eroaa perinteisistä RDBMS-tietokannoista, joissa käytetään jäsenneltyä kyselykieltä. Siinä käytetään skeemadokumentteja ja myös tietojen varastoinnin rakenne on erilainen, ja siksi ne ovat hyödyllisiä suuren tietomäärän säilyttämisessä. Se on alustaympäristöjen välinen asiakirjakeskeinen suunnittelu- ja tietokantaohjelma, joka käyttää JSON-tapaisia dokumentteja yhdessä skeeman kanssa. Tästä tulee erittäin hyödyllinen käyttötapaus operatiivisten tietojen varastoinnissa useimmissa rahoituslaitoksissa ja pyrkii siten korvaamaan perinteiset pääkehykset. MongoDB käsittelee joustavuutta ja myös monenlaista tietotyyppiä suurilla määrillä ja hajautettujen arkkitehtuurien keskuudessa.

2. MongoDB : Toinen erittäin tärkeä ja tärkeä osa suurten tietotekniikoiden varastointia on MongoDB NoSQL-tietokanta. Se on NoSQL-tietokanta, mikä tarkoittaa, että relaatiominaisuudet ja muut RDBMS: ään liittyvät ominaisuudet eivät koske sitä. Se eroaa perinteisistä RDBMS-tietokannoista, joissa käytetään jäsenneltyä kyselykieltä. Siinä käytetään skeemadokumentteja ja myös tietojen varastoinnin rakenne on erilainen, ja siksi ne ovat hyödyllisiä suuren tietomäärän säilyttämisessä. Se on alustaympäristöjen välinen asiakirjakeskeinen suunnittelu- ja tietokantaohjelma, joka käyttää JSON-tapaisia dokumentteja yhdessä skeeman kanssa. Tästä tulee erittäin hyödyllinen käyttötapaus operatiivisten tietojen varastoinnissa useimmissa rahoituslaitoksissa ja pyrkii siten korvaamaan perinteiset pääkehykset. MongoDB käsittelee joustavuutta ja myös monenlaista tietotyyppiä suurilla määrillä ja hajautettujen arkkitehtuurien keskuudessa.

3. Hunk : Se on hyödyllinen pääsy tietoihin etäisten Hadoop-klusterien kautta käyttämällä virtuaalihakemistoja ja käyttää myös Splunk-haun prosessointikieltä, jota voidaan käyttää tietojen analysointiin. Kimpaleella voidaan ilmoittaa ja visualisoida valtavia määriä tietoja Hadoop- ja NoSQL-tietokannoista ja lähteistä. Sen on kehittänyt Splunk-tiimi vuonna 2013, joka kirjoitettiin Java-kielellä.

3. Hunk : Se on hyödyllinen pääsy tietoihin etäisten Hadoop-klusterien kautta käyttämällä virtuaalihakemistoja ja käyttää myös Splunk-haun prosessointikieltä, jota voidaan käyttää tietojen analysointiin. Kimpaleella voidaan ilmoittaa ja visualisoida valtavia määriä tietoja Hadoop- ja NoSQL-tietokannoista ja lähteistä. Sen on kehittänyt Splunk-tiimi vuonna 2013, joka kirjoitettiin Java-kielellä.

4. Cassandra : Cassandra on ylin valinta suosittujen NoSQL-tietokantojen luettelosta, joka on ilmainen ja avoimen lähdekoodin tietokanta, jota levitetään ja jolla on laaja sarakkeistallennustila ja joka pystyy käsittelemään tehokkaasti suurten hyödykeryhmien tietoja eli sitä käytetään tarjota korkea käytettävyys ilman yhtäkään vikakohtaa. Tärkeimpien ominaisuuksien luettelossa on sellaisia, kuten hajautettu luonne, skaalautuvuus, vikasietoinen mekanismi, MapReduce-tuki, viritettävä johdonmukaisuus, kyselykielen ominaisuus, tukee usean tietokeskuksen replikaatiota ja mahdollista johdonmukaisuutta.

4. Cassandra : Cassandra on ylin valinta suosittujen NoSQL-tietokantojen luettelosta, joka on ilmainen ja avoimen lähdekoodin tietokanta, jota levitetään ja jolla on laaja sarakkeistallennustila ja joka pystyy käsittelemään tehokkaasti suurten hyödykeryhmien tietoja eli sitä käytetään tarjota korkea käytettävyys ilman yhtäkään vikakohtaa. Tärkeimpien ominaisuuksien luettelossa on sellaisia, kuten hajautettu luonne, skaalautuvuus, vikasietoinen mekanismi, MapReduce-tuki, viritettävä johdonmukaisuus, kyselykielen ominaisuus, tukee usean tietokeskuksen replikaatiota ja mahdollista johdonmukaisuutta.

Seuraavaksi puhutaan ison tietotekniikan eri aloista, ts. Data Mining.

5. Presto : Se on suosittu avoimen lähdekoodin ja SQL-pohjainen hajautettu hakukone, jota käytetään interaktiivisten kyselyiden suorittamiseen jokaisen asteikon tietolähteitä vastaan ja koko vaihtelee gigatavuista Petabyteihin. Sen avulla voimme hakea tietoja Cassandra-, Hive-, omistusoikeudellisissa tietovarastoissa ja relaatiotietokantojen tallennusjärjestelmissä. Tämä on Java-pohjainen kyselymoottori, jonka Apache-säätiö kehitti vuonna 2013. Muutama joukko yrityksiä, jotka hyödyntävät Presto-työkalua hyvin, ovat Netflix, Airbnb, Checkr, Repro ja facebook.

5. Presto : Se on suosittu avoimen lähdekoodin ja SQL-pohjainen hajautettu hakukone, jota käytetään interaktiivisten kyselyiden suorittamiseen jokaisen asteikon tietolähteitä vastaan ja koko vaihtelee gigatavuista Petabyteihin. Sen avulla voimme hakea tietoja Cassandra-, Hive-, omistusoikeudellisissa tietovarastoissa ja relaatiotietokantojen tallennusjärjestelmissä. Tämä on Java-pohjainen kyselymoottori, jonka Apache-säätiö kehitti vuonna 2013. Muutama joukko yrityksiä, jotka hyödyntävät Presto-työkalua hyvin, ovat Netflix, Airbnb, Checkr, Repro ja facebook.

6. ElasticSearch : Tämä on nykyään erittäin tärkeä työkalu etsinnässä. Tämä muodostaa olennaisen osan ELK-pinosta eli joustavaa hakua, Logstashia ja Kibanaa. ElasticSearch on Lucene-kirjastopohjainen hakukone, joka on samankaltainen kuin Solr ja jota käytetään tarjoamaan puhdasta jakelua, kokonaista tekstiä sisältävä hakukone, joka pystyy useisiin vuokralaisiin. Siinä on luettelo schemattomista JSON-asiakirjoista ja HTTP-verkkoliitäntä. Se on kirjoitettu kielellä JAVA, ja sen on kehittänyt Elastic-yritys yrityksessä 2012. Muutaman joustavaa hakua hyödyntävän yrityksen nimet ovat: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture jne.

6. ElasticSearch : Tämä on nykyään erittäin tärkeä työkalu etsinnässä. Tämä muodostaa olennaisen osan ELK-pinosta eli joustavaa hakua, Logstashia ja Kibanaa. ElasticSearch on Lucene-kirjastopohjainen hakukone, joka on samankaltainen kuin Solr ja jota käytetään tarjoamaan puhdasta jakelua, kokonaista tekstiä sisältävä hakukone, joka pystyy useisiin vuokralaisiin. Siinä on luettelo schemattomista JSON-asiakirjoista ja HTTP-verkkoliitäntä. Se on kirjoitettu kielellä JAVA, ja sen on kehittänyt Elastic-yritys yrityksessä 2012. Muutaman joustavaa hakua hyödyntävän yrityksen nimet ovat: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture jne.

Nyt luetaan kaikista niistä isoista tietotekniikoista, jotka ovat osa data-analytiikkaa:

7. Apache Kafka : tunnetaan julkaisuista, tilauksista tai pub-subistä, joista tunnetaan yleisesti nimellä, on suora viestintä, asynkroninen viestintävälitysjärjestelmä, jota käytetään syöttämään ja suorittamaan tietojen käsittely reaaliaikaista suoratoistotietoa varten. Se tarjoaa myös säilytysjakson ja tiedot voidaan kanavoida tuottaja-kuluttaja-mekanismin avulla. Se on yksi suosituimmista suoratoistoalustoista, joka on hyvin samanlainen kuin yrityksen viestijärjestelmä tai viestijono. Kafka on käynnistänyt useita parannuksia tähän päivään mennessä, ja eräs tärkeä tyyppi on Kafkan risteyksessä oleva, joka tarjoaa Kafkalle ylimääräisiä ominaisuuksia, kuten Schema-rekisteri, Ktables, KSql jne. Sen kehitti Apache Software -yhteisö vuonna 2011 ja on kirjoitettu Java-kielellä. Tätä tekniikkaa käyttäviä yrityksiä ovat Twitter, Spotify, Netflix, Linkedin, Yahoo jne.

7. Apache Kafka : tunnetaan julkaisuista, tilauksista tai pub-subistä, joista tunnetaan yleisesti nimellä, on suora viestintä, asynkroninen viestintävälitysjärjestelmä, jota käytetään syöttämään ja suorittamaan tietojen käsittely reaaliaikaista suoratoistotietoa varten. Se tarjoaa myös säilytysjakson ja tiedot voidaan kanavoida tuottaja-kuluttaja-mekanismin avulla. Se on yksi suosituimmista suoratoistoalustoista, joka on hyvin samanlainen kuin yrityksen viestijärjestelmä tai viestijono. Kafka on käynnistänyt useita parannuksia tähän päivään mennessä, ja eräs tärkeä tyyppi on Kafkan risteyksessä oleva, joka tarjoaa Kafkalle ylimääräisiä ominaisuuksia, kuten Schema-rekisteri, Ktables, KSql jne. Sen kehitti Apache Software -yhteisö vuonna 2011 ja on kirjoitettu Java-kielellä. Tätä tekniikkaa käyttäviä yrityksiä ovat Twitter, Spotify, Netflix, Linkedin, Yahoo jne.

8. Splunk : Splunkia käytetään reaaliaikaisen streaming-tiedon sieppaamiseen, korreloimiseen ja indeksointiin haettavissa olevasta arkistosta, josta se voi luoda raportteja, kaavioita, kojetauluja, hälytyksiä ja tietojen visualisointeja. Sitä käytetään myös tietoturvaan, vaatimustenmukaisuuden ja sovellusten hallintaan sekä web-analytiikkaan, liikeideoiden tuottamiseen ja liiketoiminta-analyysiin. Sen on kehittänyt Splunk Pythonissa, XML, Ajax.

8. Splunk : Splunkia käytetään reaaliaikaisen streaming-tiedon sieppaamiseen, korreloimiseen ja indeksointiin haettavissa olevasta arkistosta, josta se voi luoda raportteja, kaavioita, kojetauluja, hälytyksiä ja tietojen visualisointeja. Sitä käytetään myös tietoturvaan, vaatimustenmukaisuuden ja sovellusten hallintaan sekä web-analytiikkaan, liikeideoiden tuottamiseen ja liiketoiminta-analyysiin. Sen on kehittänyt Splunk Pythonissa, XML, Ajax.

9. Apache Spark : Nyt on kriittisin ja odotetuin tekniikka suurten tietotekniikoiden eli Apache Spark -alueella. Se on mahdollisesti nykyään eniten kysyttyjä ja käyttää prosessointiin Java-, Scala- tai Python-ohjelmia. Tätä käytetään käsittelemään ja käsittelemään reaaliaikaista suoratoistotietoa käyttämällä Spark Streaming -toimintoa, joka käyttää erä- ja ikkunaoperaatioita tapahtumaan. Spark SQL: ää käytetään tietokehysten, tietojoukkojen luomiseen RDD-levyjen päälle ja siten tarjotaan hyvä maku muunnoksille ja toimille, jotka muodostavat olennaisen osan Apache Spark Core -sovellusta. Muut komponentit, kuten Spark Mllib, R ja graphX, ovat myös hyödyllisiä analyyseissä ja koneoppimisessa ja tietojenkäsittelyssä. Muistin sisäinen laskentatekniikka erottaa sen muista työkaluista ja komponenteista ja tukee monenlaisia sovelluksia. Sen on kehittänyt Apache Software -säätiö ensisijaisesti Java-kielellä.

9. Apache Spark : Nyt on kriittisin ja odotetuin tekniikka suurten tietotekniikoiden eli Apache Spark -alueella. Se on mahdollisesti nykyään eniten kysyttyjä ja käyttää prosessointiin Java-, Scala- tai Python-ohjelmia. Tätä käytetään käsittelemään ja käsittelemään reaaliaikaista suoratoistotietoa käyttämällä Spark Streaming -toimintoa, joka käyttää erä- ja ikkunaoperaatioita tapahtumaan. Spark SQL: ää käytetään tietokehysten, tietojoukkojen luomiseen RDD-levyjen päälle ja siten tarjotaan hyvä maku muunnoksille ja toimille, jotka muodostavat olennaisen osan Apache Spark Core -sovellusta. Muut komponentit, kuten Spark Mllib, R ja graphX, ovat myös hyödyllisiä analyyseissä ja koneoppimisessa ja tietojenkäsittelyssä. Muistin sisäinen laskentatekniikka erottaa sen muista työkaluista ja komponenteista ja tukee monenlaisia sovelluksia. Sen on kehittänyt Apache Software -säätiö ensisijaisesti Java-kielellä.

10. R-kieli : R on ohjelmointikieli ja vapaa ohjelmistoympäristö, jota käytetään tilastolliseen laskentaan ja myös grafiikkaan yhdellä tärkeimmistä kielistä R: ssä. Tämä on yksi tietotekijöiden, tiedonhakijoiden ja tietoharjoittajat tilastollisten ohjelmistojen kehittämiseen ja pääasiassa data-analytiikkaan.

10. R-kieli : R on ohjelmointikieli ja vapaa ohjelmistoympäristö, jota käytetään tilastolliseen laskentaan ja myös grafiikkaan yhdellä tärkeimmistä kielistä R: ssä. Tämä on yksi tietotekijöiden, tiedonhakijoiden ja tietoharjoittajat tilastollisten ohjelmistojen kehittämiseen ja pääasiassa data-analytiikkaan.

Keskustelemme nyt tiedon visualisointiin liittyvistä tekniikoista.

11. Tableau: Se on nopein ja tehokas kasvava datan visualisointityökalu, jota käytetään yritystietojen hallinta-alueella. Tietoanalyysi on erittäin nopea kone, joka on mahdollista Tableaun avulla ja visualisoinnit luodaan laskentataulukoiden ja kojetaulujen muodossa. Sen on kehittänyt tableau-yritys vuonna 2013, ja se on kirjoitettu Python-, C ++-, Java- ja C-yrityksissä. Yrityksiä, jotka käyttävät Tableau: ta, ovat: QlikQ, Oracle Hyperion, Cognos jne.

11. Tableau: Se on nopein ja tehokas kasvava datan visualisointityökalu, jota käytetään yritystietojen hallinta-alueella. Tietoanalyysi on erittäin nopea kone, joka on mahdollista Tableaun avulla ja visualisoinnit luodaan laskentataulukoiden ja kojetaulujen muodossa. Sen on kehittänyt tableau-yritys vuonna 2013, ja se on kirjoitettu Python-, C ++-, Java- ja C-yrityksissä. Yrityksiä, jotka käyttävät Tableau: ta, ovat: QlikQ, Oracle Hyperion, Cognos jne.

12. Plotly : Plotly : tä käytetään pääasiassa graafien ja niihin liittyvien komponenttien tekemiseen nopeammiksi ja tehokkaammiksi. Sillä on rikkaampi kirjasto- ja sovellusliittymäjoukko, kuten MATLAB, Python, R, Arduino, Julia, jne. Tätä voidaan käyttää vuorovaikutteisesti Jupyter-kannettavassa ja Pycharmissa ja sitä voidaan käyttää vuorovaikutteisten kuvaajien tyylistamiseen. Se kehitettiin ensimmäisen kerran vuonna 2012 ja kirjoitettiin javascriptinä. Harvat yritykset, jotka käyttävät Plotlyä, ovat paladins, bitbank jne.

12. Plotly : Plotly : tä käytetään pääasiassa graafien ja niihin liittyvien komponenttien tekemiseen nopeammiksi ja tehokkaammiksi. Sillä on rikkaampi kirjasto- ja sovellusliittymäjoukko, kuten MATLAB, Python, R, Arduino, Julia, jne. Tätä voidaan käyttää vuorovaikutteisesti Jupyter-kannettavassa ja Pycharmissa ja sitä voidaan käyttää vuorovaikutteisten kuvaajien tyylistamiseen. Se kehitettiin ensimmäisen kerran vuonna 2012 ja kirjoitettiin javascriptinä. Harvat yritykset, jotka käyttävät Plotlyä, ovat paladins, bitbank jne.

johtopäätös

Tässä viestissä olemme tutkineet huipputason suuria tietotekniikoita, jotka ovat nykyään laajalti käytössä. Toivottavasti pidit siitä. Seuraa edelleen meitä saadaksesi lisää tällaisia viestejä.

Suositellut artikkelit

Tämä on opas Big Data Technologies -yritykseen. Täällä olemme keskustelleet Big Data Technologies -aloitteen esittelystä ja tyypeistä. Voit myös käydä läpi muiden ehdotettujen artikkeleidemme saadaksesi lisätietoja -

- Mikä on Splunk-työkalu?

- R vs Python

- Mikä on Matlab?

- Mikä on MongoDB?

- Seuraavia vaiheita mainframe-testauksessa

- Spark SQL: n liitostyypit (esimerkit)

- Opi Kafka-työkalujen erityypit