Mikä on NLP Pythonissa?

Keinotekoinen älykkyys on kehittynyt valtavasti viimeisen vuosikymmenen aikana, joten se on yksi sen ala-alueista - Luonnollisen kielen käsittely. AI: n kehitys on seurausta nykyaikaisten järjestelmien valtavasta laskennallisesta kapasiteetista ja suurista määristä jäsentämättömiä tietoja, jotka tullaan tuottamaan monista lähteistä. Luonnollisen kielen käsittely tai NLP on AI: n tutkimus, jonka avulla tietokoneet voivat käsitellä raakatonta jäsentämätöntä tekstitietoa ja poimia siitä piilotettuja oivalluksia.

Määritelmä

Toisin kuin ihmiset, tietokoneet eivät ole tarpeeksi älykkäitä käsittelemään jäsentämätöntä tietoa. Ihmiset voisivat saada merkityksiä tällaisesta tiedosta, kun taas tietokoneet voivat tehdä sen vain tietokantoihin tallennetun jäsennellyn datan avulla. Tietokoneet käyttävät NLP: n työkaluja ja tekniikoita sellaisen datan käsittelemiseksi löytääkseen malleja ja saadakseen merkityksen luonnollisesta tiedosta.

Kuinka NLP toimii Pythonissa?

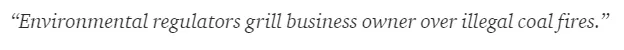

Englannin kielen lukeminen ja ymmärtäminen on erittäin monimutkaista. Alla oleva lause on yksi sellainen esimerkki, jossa tietokoneen on todella vaikea ymmärtää lauseen taustalla olevaa todellista ajatusta.

Koneoppimisessa rakennetaan putkilinja jokaiselle ongelmalle, jossa jokainen ongelman osa ratkaistaan erikseen ML: n avulla. Lopputulos olisi yhdistelmä useita ketjutettuja koneoppimismalleja. Luonnollinen kielenkäsittely toimii samalla tavalla, kun englanninkielinen lause on jaettu paloiksi.

Tässä kappaleessa on useita tosiseikkoja. Asiat olisivat olleet helppoja, jos tietokoneet itse ymmärtäisivät mitä Lontoo on, mutta tietokoneiden on sitä varten koulutettava kirjallisen kielen peruskäsitteillä.

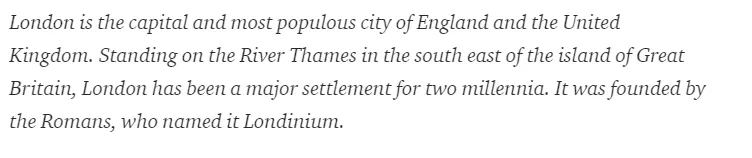

1. Lauseiden segmentointi - Korpus on jaettu useisiin lauseisiin kuten alla.

Tämä helpottaisi elämäämme, koska on parempi käsitellä yksi lause kuin kokonainen kappale. Jako voitaisiin suorittaa välimerkien tai useiden muiden monimutkaisten tekniikoiden perusteella, jotka toimivat myös puhdistamattomissa tiedoissa.

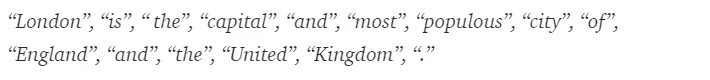

2. Sana-tokenisointi - Lause voitaisiin edelleen jakaa sanatunnisteeseen alla esitetyllä tavalla.

Tokenoinnin jälkeen yllä oleva lause jaetaan -

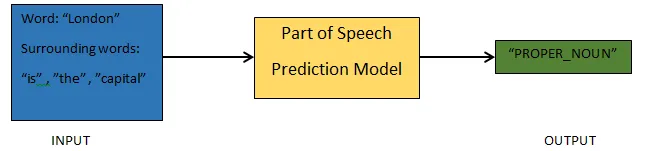

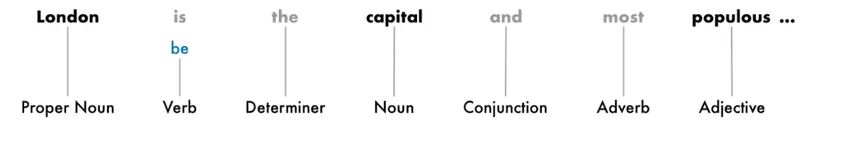

3. Puheen ennusteen osat - Tämä prosessi tarkoittaa puheosien tuottamista jokaiselle merkille. Tämän avulla voisimme ymmärtää lauseen merkityksen ja aiheen, josta puhutaan lauseessa.

4. Lemmaisointi - Sana lauseessa voi esiintyä eri muodoissa. Lemmatization seuraa sanan takaisin sen juureen eli kunkin sanan lemmaan.

5. Pysäytä sanojen tunnistaminen - Lauseessa on paljon täytesanoja, kuten '' ', ' a '. Nämä sanat toimivat kuin kohina tekstissä, jonka merkitystä yritämme purkaa. Siksi on välttämätöntä suodattaa nämä pysäytyssanat paremman mallin luomiseksi.

Sovelluksen perusteella lopetussanat voivat vaihdella. On kuitenkin olemassa ennalta määritelty luettelo pysäytystoiminnoista, joihin voitaisiin viitata.

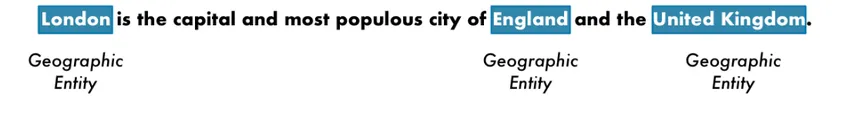

6. Nimeltään entiteetin tunnistus - NER on prosessi, jolla etsitään lauseesta yksiköitä, kuten nimi, paikka, henkilö, organisaatio jne.

Tässä käytetään sanan ilmaisun kontekstia lauseessa. NER-järjestelmillä on paljon käyttöjä strukturoidun tiedon poistamiseksi tekstistä.

Esimerkki NLP: stä Pythonissa

Useimmat yritykset ovat nyt halukkaita käsittelemään jäsentämätöntä tietoa liiketoiminnan kasvattamiseksi. NLP: llä on laaja käyttöalue, ja yleisimpiä käyttötapoja on tekstiluokittelu.

Tekstin luokittelu automaattisesti eri luokkiin kutsutaan tekstiluokitukseksi. Roskapostin tai kinkun havaitseminen sähköpostissa, uutisartikkeleiden luokittelu ovat joitain yleisimpiä esimerkkejä tekstin luokittelusta. Tätä tarkoitusta varten käytetyt tiedot on merkittävä.

Muutamia vaiheita tekstinluokitusputkessa, joita on noudatettava, ovat -

- Tietojen lataaminen ja esikäsittely on ensimmäinen askel, ja sitten ne jaettaisiin junaan ja validointijoukkoon.

- Ominaisuuksien suunnitteluvaihe sisältää hyödyllisten ominaisuuksien purkamisen tai merkityksellisten lisäominaisuuksien luomisen, jotka auttaisivat kehittämään parempaa ennustemallia.

- Mallin rakentamiseksi merkittyä tietojoukkoa käytetään mallin kouluttamiseen.

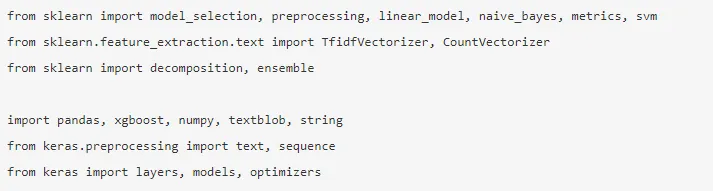

Pandat, Scikit-oppi, XGBoost, TextBlog, Keras ovat harvat tarvittavista kirjastoista, jotka meidän on asennettava. Tuomme sitten kirjastoja aineistojen valmisteluun, ominaisuuksien suunnitteluun jne.

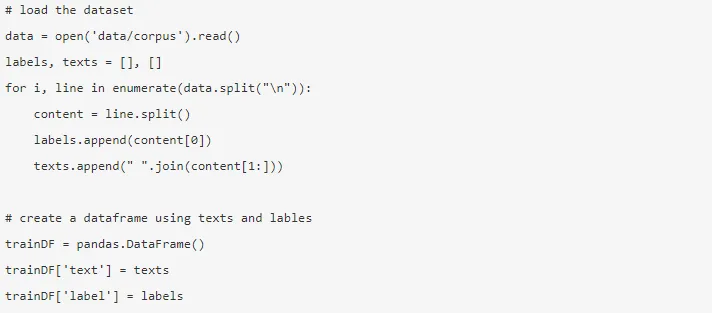

Tiedot ovat valtavat, ja täältä voi ladata lähes 3, 6 miljoonaa arviota. Murtoa dataa käytetään. Se ladataan ja luetaan Pandan tietokehykseen.

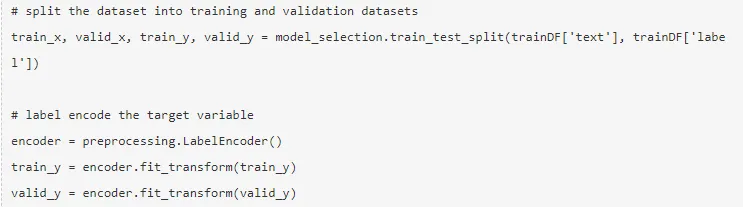

Kohdemuuttuja koodataan ja tiedot jaetaan junaan ja testijoukkoihin.

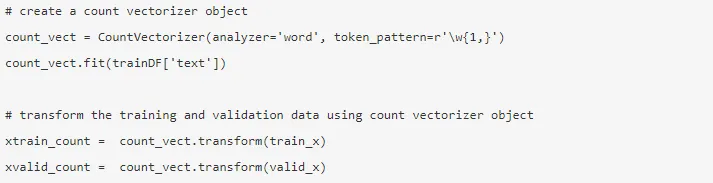

Ominaisuuksien suunnittelu suoritetaan käyttämällä alla olevia eri menetelmiä.

1. Laskemisvektorit - Asiakirjan, termin ja sen taajuuden esitys korpuksesta saavutetaan laskurivektoreilla.

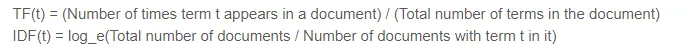

2. TF-IDF-vektorit - Asiakirjassa termin suhteellista merkitystä edustavat termintaajuus (TF) ja käänteisen asiakirjan taajuus (IDF) -pistemäärä. TF-IDF voidaan laskea -

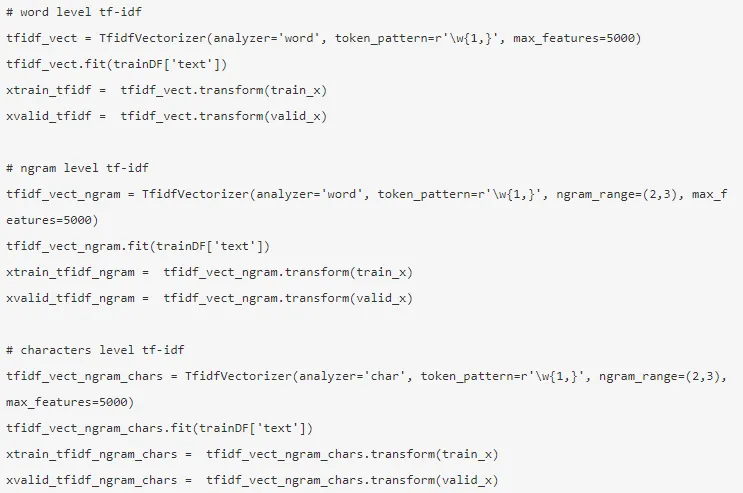

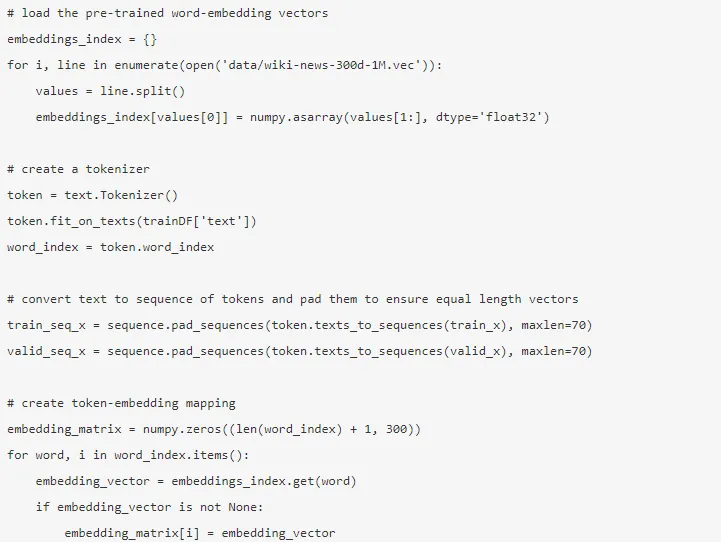

TF-IDF-vektorit voitaisiin generoida Word-tasolla, joka esittää jokaisen termin pistemäärä, ja N-grammatasolla, joka on n-termien yhdistelmä.

3. Sanan upottaminen - Asiakirjojen ja sanojen esitys tiheän vektorin muodossa kutsutaan sanan upotukseksi. On valmiiksi koulutettuja upotuksia, kuten Glove, Word2Vec, joita voidaan käyttää tai joita voidaan myös kouluttaa.

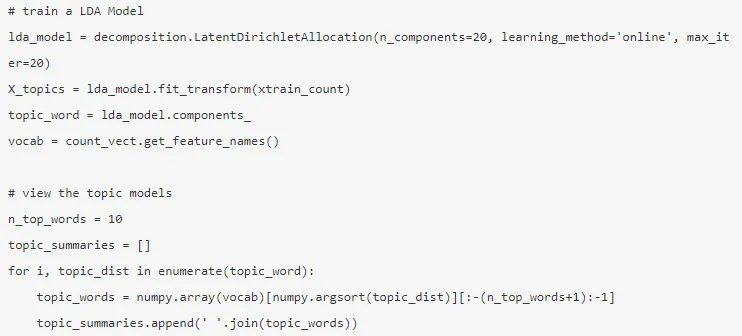

4. Aihemallit - Asiakirjan sanaryhmä sisältää eniten tietoa. Latentti Dirichlet-allokointia käytetään tässä aihemallinnukseen.

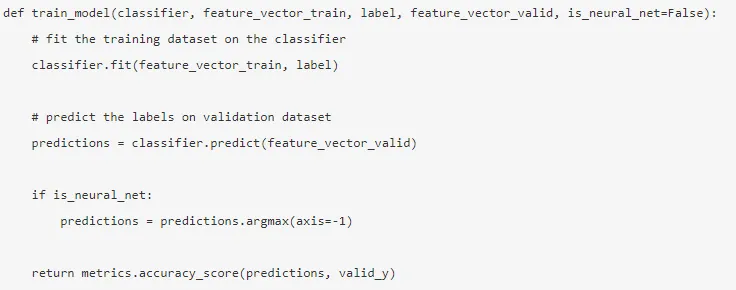

Tila on rakennettu sen jälkeen kun ominaisuuksien suunnittelu on tehty ja asiaan liittyvät ominaisuudet on poistettu.

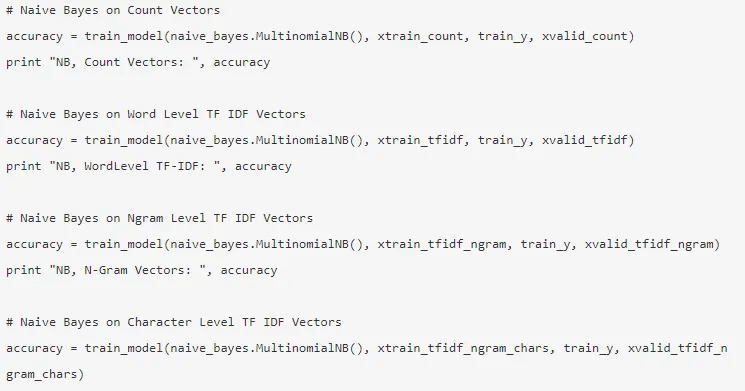

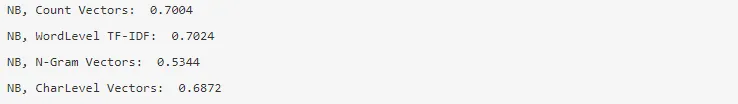

5. Naiivi Bayes - Se perustuu Bayes-lauseeseen, ja algoritmi uskoo, että tietojoukon ominaisuuksien välillä ei ole yhteyttä.

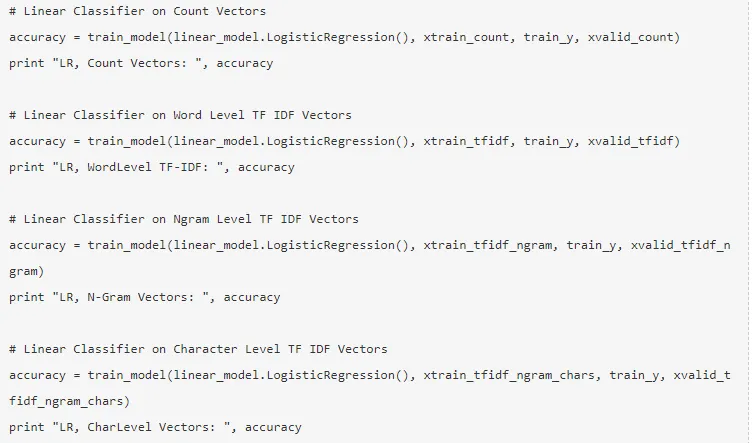

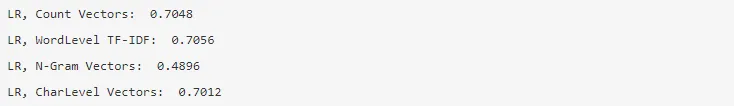

6. Logistinen regressio - Se mittaa ominaisuuksien välistä lineaarista suhdetta, ja kohdemuuttuja mitataan sigmoidifunktiolla, joka estimoi todennäköisyydet.

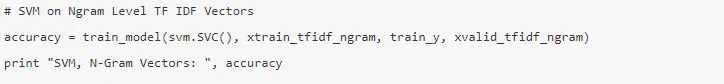

7. Support Vector Machine - Hyperplane erottaa kaksi luokkaa SVM: ssä.

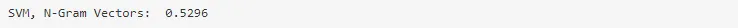

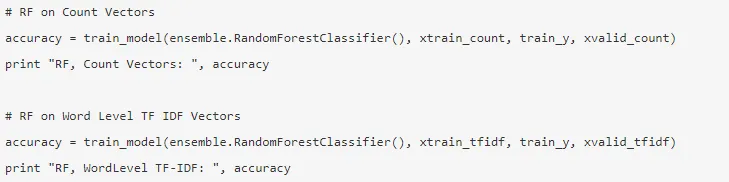

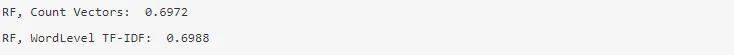

8. Satunnainen metsämalli - Kokoonpanomalli, joka vähentää varianssia ja pussittaa useita päätöspuita yhteen.

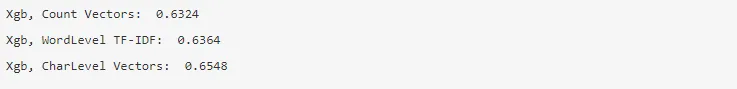

9. XG Boost - Bias vähenee, ja heikot oppijat muuttuvat vahvoiksi.

Kuinka NLP auttaisi sinua urallasi?

Luonnollisen kielen käsittely on markkinoilla kukoistava kenttä, ja melkein jokainen organisaatio tarvitsee NLP-insinöörin auttamaan heitä käsittelemään raakatietoja. Siksi on välttämätöntä hallita tarvittavat taidot, koska markkinoilla ei olisi pulaa työpaikoista.

Johtopäätös: NLP Pythonissa

Aloitimme tässä artikkelissa johdannon NLP: ään Pythonissa ja otimme sitten käyttöön yhden käyttötavan Pythonissa osoittaaksesi kuinka työskennellä NLP: n kanssa Pythonissa.

Suositellut artikkelit

Tämä on ollut opas NLP: lle Pythonissa. Tässä keskustelimme esimerkistä, käyttötapauksista ja kuinka työskennellä NLP: n kanssa Pythonissa. Voit myös käydä läpi muiden ehdotettujen artikkeleidemme saadaksesi lisätietoja -

- Pythonin käyttö

- Mikä on WBS?

- Python vs Scala

- Mikä on Tableau?