Katsaus koneoppimisen menetystoiminnoista

Aivan kuten opettajat opastavat meitä, menestymmekö hyvin vai ei yliopistoissamme, menetystoiminnot tekevät saman työn. Se on menetelmä arvioida, kuinka hyvin algoritmimme mallii tietoja. Tappiofunktiot ovat tärkein arvioinnin lähde nykyaikaisessa koneoppimisessa. Kun muutat algoritmiasi mallin parantamiseksi, häviöfunktion arvo kertoo sinulle, edistytkö vai ei. Ensisijaisen tavoitteemme pitäisi olla häviöfunktion vähentäminen optimoimalla. Tässä artikkelissa aiomme keskustella siitä, miten häviötoiminnot toimivat ja erityyppisiä häviötoimintoja.

Kuinka tappiotoiminnot toimivat?

Sana "Tappio" ilmaisee rangaistuksen odotetun tuloksen saavuttamatta jättämisestä. Jos mallimme ennustetun arvon poikkeama odotetusta arvosta on suuri, häviöfunktio antaa suuremman määrän tulosteena ja jos poikkeama on pieni ja paljon lähempänä odotettua arvoa, se antaa pienemmän luvun.

Tässä on esimerkki, kun yritämme ennustaa talomyynnin hintaa metrokaupungeissa.

| ennusti

Myyntihinta (lakh) | Todellinen

Myyntihinta (lakh) | Poikkeama (häviö) |

| Bangalore: 45 | 0 (kaikki ennusteet ovat oikein) | |

| Pune: 35 | ||

| Chennai: 40 | ||

| Bangalore: 40 | Bangalore: 45 | 5 lakh Bangaloressa, 2 lakh Chennaissa |

| Pune: 35 | Pune: 35 | |

| Chennai: 38 | Chennai: 40 | |

| Bangalore: 43 | 2 lakh Bangaloressa, 5 lakh for, Pune2 lakh Chennaissa, | |

| Pune: 30 | ||

| Chennai: 45 |

On tärkeää huomata, että poikkeaman määrällä ei ole merkitystä, tässä on merkitystä sillä, onko mallimme ennustama arvo oikea vai väärä. Tappiofunktiot ovat erilaisia sen ongelmalausunnon perusteella, johon koneoppimista sovelletaan. Kustannusfunktio on toinen termi, jota käytetään korvaavasti tappiofunktiossa, mutta sillä on hiukan erilainen merkitys. Tappiofunktio on yksittäinen harjoitteluesimerkki, kun taas kustannusfunktio on keskimääräinen menetys koko juna-aineistossa.

Koneoppimisen menetystoimintojen tyypit

Seuraavassa on erityyppisiä tappiofunktioita koneoppimisessa, jotka ovat seuraavat:

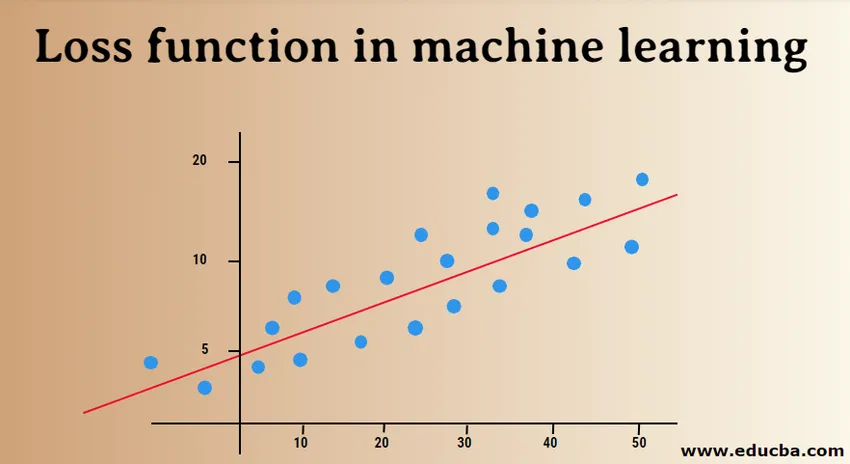

1) Regressiohäviöfunktiot:

Lineaarinen regressio on tämän funktion perusajatus. Regressiohäviöfunktiot muodostavat lineaarisen suhteen riippuvaisen muuttujan (Y) ja riippumattoman muuttujan (X) välillä, joten yritämme sovittaa parhaan rivin avaruuteen näihin muuttujiin.

Y = X0 + X1 + X2 + X3 + X4 … + Xn

X = riippumattomat muuttujat

Y = Riippuva muuttuja

- Keskimääräinen neliövirhehäviö:

MSE (L2-virhe) mittaa mallin todellisten ja ennustettujen arvojen keskimääräisen neliöeron. Lähtö on yksittäinen luku, joka liittyy arvojoukkoon. Tavoitteenamme on vähentää MSE: tä mallin tarkkuuden parantamiseksi.

Tarkastellaan lineaarista yhtälöä, y = mx + c, voimme johtaa MSE: n:

MSE = 1 / N ∑i = 1 - n (y (i) - (mx (i) + b)) 2

Tässä N on datapisteiden kokonaismäärä, 1 / N ∑i = 1 - n on keskiarvo ja y (i) on todellinen arvo ja mx (i) + b sen ennustetun arvon.

- Keskimääräinen neliön logaritminen virhehäviö (MSLE):

MSLE mittaa todellisen ja ennustetun arvon välisen suhteen. Se tuo epäsymmetrian virhekäyrään. MSLE välittää vain todellisten ja ennustettujen arvojen prosentuaalisista eroista. Se voi olla hyvä valinta tappiofunktiona, kun haluamme ennustaa asuntojen myyntihintoja, leipomomyynnin hintoja ja tiedot ovat jatkuvia.

Tappio voidaan laskea tässä havaittujen tietojen keskiarvona log-muunnettujen todellisten ja ennustettujen arvojen välisten neliöerojen perusteella, jotka voidaan antaa seuraavasti:

L = 1nnΣi = 1 (log (y (i) + 1) -log (y (i) + 1)) 2

- Keskimääräinen absoluuttinen virhe (MAE):

MAE laskee todellisten ja ennustettujen muuttujien välisten absoluuttisten erojen summan. Tämä tarkoittaa, että se mittaa virheiden keskimääräisen suuruuden ennustetussa arvossa. Keskimääräisen neliövirheen käyttäminen on helpompi ratkaista, mutta absoluuttisen virheen käyttäminen on vahvempaa poikkeaville. Poikkeamat ovat niitä arvoja, jotka poikkeavat huomattavasti muista havaituista datapisteistä.

MAE voidaan laskea seuraavasti:

L = 1nnΣi = 1||y (i) - y (i) ||

2) Binaariluokituksen menetystoiminnot:

Nämä häviöfunktiot tehdään luokitusmallin suorituskyvyn mittaamiseksi. Tässä datapisteille annetaan yksi tarroista, ts. Joko 0 tai 1. Lisäksi ne voidaan luokitella seuraavasti:

- Binaarinen risti-entropia

Se on oletushäviötoiminto binaariluokitteluongelmiin. Ristien entropian menetys laskee luokittelumallin suorituskyvyn, joka antaa ulostulon todennäköisyysarvon välillä 0 - 1. Ristien entropian häviö kasvaa, kun ennustettu todennäköisyysarvo poikkeaa todellisesta merkinnästä.

- Saranan menetys

Saranan menetystä voidaan käyttää vaihtoehtona ristin entropialle, joka kehitettiin alun perin käytettäväksi tukivektorikoneen algoritmin kanssa. Saranan menetys toimii parhaiten luokitteluongelman kanssa, koska tavoitearvot ovat joukossa (-1, 1). Sen avulla voidaan määrittää enemmän virheitä, kun merkissä on ero todellisten ja ennustettujen arvojen välillä. Siksi tuloksena on parempi suorituskyky kuin ristin entropiaa.

- Ruudun saranan menetys

Saranan menetyspidennys, joka yksinkertaisesti laskee saranan menetyspisteen neliön. Se vähentää virhetoimintoa ja helpottaa sen käsittelyä numeerisesti. Se löytää luokitusrajan, joka määrittelee suurimman marginaalin eri luokkien datapisteiden välillä. Ruudun saranan menetys sopii täydellisesti KYLLÄ tai EI sellaisiin päätöksentekoon liittyviin ongelmiin, joissa todennäköisyyspoikkeama ei ole huolenaihe.

3) Moniluokkainen luokitteluhäviötoiminnot:

Moniluokkainen luokittelu on ennustava malli, jossa datapisteet osoitetaan useampaan kuin kahteen luokkaan. Jokaiselle luokalle annetaan yksilöllinen arvo välillä 0 - (luokan_luokat - 1). Sitä suositellaan erittäin hyvin kuva- tai tekstiluokitusongelmiin, joissa yhdellä paperilla voi olla useita aiheita.

- Moniluokkainen risti-entropia

Tässä tapauksessa tavoitearvot ovat joukossa 0 - n, ts. (0, 1, 2, 3 … n). Se laskee pisteet, joka vie keskimääräisen eron todellisten ja ennustettujen todennäköisyysarvojen välillä, ja pistemäärä minimoidaan parhaan mahdollisen tarkkuuden saavuttamiseksi. Moniluokkainen risti-entroopia on oletushäviöfunktio tekstien luokitteluongelmiin.

- Harva moniluokkainen risti-entroopia

Yksi kuuma koodausprosessi tekee moniluokkaisesta ristiennestämisestä vaikean käsitellä suurta määrää datapisteitä. Harva risti-entroopia ratkaisee tämän ongelman suorittamalla virhelaskelman käyttämättä yhtä kuumaa koodausta.

- Kullback Leibler -erohäviö

KL-divergenssitappio laskee todennäköisyysjakauman ja lähtötason jakauman välisen eron ja selvittää, kuinka paljon tietoa menetetään bitteinä. Tulos on ei-negatiivinen arvo, joka määrittelee kuinka lähellä todennäköisyysjakaumaa ovat. KL-erottelun kuvaamiseksi todennäköisyysnäkymällä käytetään todennäköisyysastetta.

Tässä artikkelissa ymmärsimme alun perin, miten häviöfunktiot toimivat, ja tutkimme sitten kattava luettelo tappiofunktioista käytetyillä tapausesimerkkeillä. Sen ymmärtäminen käytännössä on kuitenkin hyödyllisempää, joten yritä lukea enemmän ja toteuttaa se. Se selvittää epäilyksesi perusteellisesti.

Suositellut artikkelit

Tämä on opas koneoppinnan menetystoimintoihin. Tässä keskustellaan kuinka häviötoiminnot toimivat ja menetystoimintojen tyypit koneoppimisessa. Saatat myös katsoa seuraavia artikkeleita saadaksesi lisätietoja -

- Koneoppimismenetelmät

- Johdanto koneoppimiseen

- Big Data Technologies

- Big Data Analytics -ohjelmisto

- Opi hyperaparametrien katogoorit

- Koneoppimisen elinkaari | 8 parasta vaihetta