Ero Hadoopin ja SQL: n välillä

Joka sekunti sosiaalisen median, kuten Facebookin, Twitterin, Instagramin, kautta tuottama valtava tieto on rakentanut tietä Hadoop / Big Data Ekosysteemin kehittämiselle. Ilmaisu ”3V”, joka viittaa äänenvoimakkuuteen, nopeuteen ja todenmukaisuuteen, määrittelee Hadoopin tärkeyden käsitellä suoratoistoa. Nykyään tietoja tuotetaan useista lähteistä, jotka on integroitava eri tarkoituksiin, kuten raportointiin, data-analyysiin ja tutkimukseen, sekä tietojen keskitettyyn varastointiin. Kun teemme niin, perinteisiin lähestymistapoihin liittyy useita ongelmia, kuten tila, pääsy, eheys, rakenne ja kaistanleveys. Kaikkien näiden kysymysten käsittelemiseksi Hadoop tarjoaa puitteet, joiden avulla voidaan käsitellä valtavan koon tietoja, tarjota helppo pääsy niihin, korkea käytettävyys ja ladata tietoja dynaamisesti. Siinä on hajautettu tiedostojärjestelmäjärjestelmä (HDFS) tietojen ja sisäänrakennetun kyselyprosessorin varastointiin nimeltä “Map Reduce” HDFS: ään tallennettujen tietojen analysointia ja käsittelyä varten.

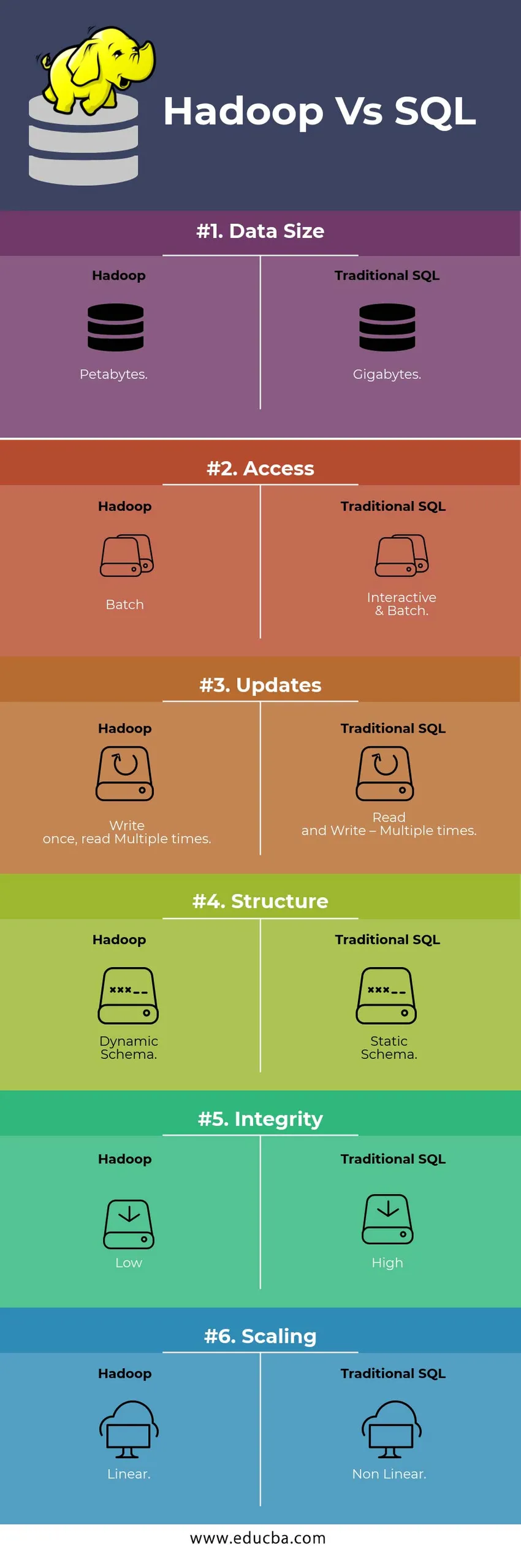

HEAD TO HEAD vertailu Hadoop Vs SQL: n välillä

Alla on kuusi tärkeintä eroa Hadoop Vs SQL: n välillä

Keskeiset erot Hadoop Vs SQL: n välillä

Alla on ero Hadoopin ja SQL: n välillä

- Kaavio WRITE Vs LUE

Yleensä perinteisessä tietokannassa tietojen lataamisen / siirron aikana tietokannasta toiseen se noudattaa kirjoituslähestymistavan kaavaa. Tämä tekee tietojen latausprosessista herätetyn / keskeytetyn ja johtaa tietueiden hylkäämiseen lähde- ja kohdetaulukoiden rakenteen erojen vuoksi. Hadoop-järjestelmässä kaikki tiedot tallennetaan HDFS: ään ja tiedot keskitetään.

Hadoop-kehystä käytetään pääasiassa Data Analytics -prosessiin. Siksi se tukee kaikkia kolmea tietoryhmää eli strukturoitua, osittain jäsentämätöntä ja jäsentämätöntä dataa ja mahdollistaa lukemista koskevan kaavion.

- Strukturoidulla tiedolla on selkeä muoto. g .: XML-tiedosto.

- Puolirakenteiden tiedot ovat löysämpiä; Sillä voi olla / ei ole kaavaa. g .: Laskentataulukko

- Strukturoimattomalla tiedolla ei ole erityistä rakennetta tai kaavaa. Esimerkiksi: teksti tai kuva.

Hadoop toimii tehokkaasti jäsentelemättömän datan kanssa, koska sillä on kyky tulkita tietoja käsittelyaikana.

| Lähestyä | Etu | Dis-etu |

| Kaava kirjoittamiseen | · Esiasetetut rakenteet

· Nopeampi lukeminen. Esimerkiksi: perinteinen RDBMS. | Hidas tiedonsiirto

Korkea viive |

| Kaavio lukemassa | · Dynaaminen rakenne

· Nopea kirjoittaminen ja lukeminen. Esimerkiksi: Hadoop | Nopea tietojen lataus

Alhainen viiveaika |

Taulukko : Kaavio WRITE VS -kaaviosta READ.

- Skaalattavuus ja kustannukset

Hadoop Framework on suunniteltu käsittelemään suurta määrää dataa. Aina kun datan koko kasvaa, joukko lisäresursseja, kuten datasolmu, voidaan lisätä klusteriin erittäin helposti kuin staattisen muistin allokoinnin perinteinen lähestymistapa. Aikaa ja budjettia on suhteellisen hyvin vähän niiden toteuttamiseen ja Hadoop tarjoaa myös datapaikkakunnan, jossa tiedot asetetaan saataville työn suorittaneessa solmussa.

- VIKASIETOISUUS

Perinteisessä RDBMS-järjestelmässä, kun tiedot menetetään korruption tai muun verkkoongelman takia, kadotetun tiedon palauttaminen vie enemmän aikaa, kustannuksia ja resursseja. Mutta Hadoopilla on mekanismi, jossa tiedoilla on vähintään kolme replikaatiotekijää HDFS: ään tallennetuille tiedoille. Jos jokin dataa pitävistä datasolmuista epäonnistuu, tietoja voidaan helposti vetää muista datasolmuista, joilla on korkea tiedon saatavuus. Siksi tiedot ovat helposti käyttäjän saatavilla riippumatta virheistä.

- TOIMINNALLINEN OHJELMOINTI

Hadoop tukee toiminnallisen ohjelmoinnin kirjoittamista kielille, kuten java, scala ja python. Kaikille sovelluksille, jotka vaativat lisätoimintoja, voidaan toteuttaa rekisteröimällä UDF-käyttäjän määrittämät toiminnot HDFS: ään. RDBMS: ssä ei ole mahdollista kirjoittaa UDF: tä ja tämä lisää SQL: n kirjoittamisen monimutkaisuutta. Lisäksi HDFS: ään tallennettuihin tietoihin pääsee kaikilla Hadoopin ekosysteemeillä, kuten pesä, sika, Sqoop ja HBase. Joten jos UDF on kirjoitettu, sitä voi käyttää mikä tahansa edellä mainituista sovelluksista. Se lisää järjestelmän suorituskykyä ja tuettavuutta.

- OPTIMOINTI

Hadoop tallentaa tietoja HDFS: ään ja prosessoida, vaikka Map Reduce -sovelluksella valtavilla optimointitekniikoilla. Suosituimpia tietojen käsittelyssä käytettyjä tekniikoita ovat tallennetun tiedon osiointi ja ämpäri. Osiointi on lähestymistapa tietojen tallentamiseen HDFS: ään jakamalla tiedot osittamiseen tarkoitetun sarakkeen perusteella. Kun tietoja injektoidaan tai ladataan HDFS: ään, se tunnistaa osiosarakkeen ja työntää tiedot kyseiseen osiohakemistoon. Joten kysely noutaa tulosjoukon hakemalla tietoja suoraan osioidusta hakemistosta. Tämä vähentää koko taulukon tarkistusta, parantaa vasteaikaa ja välttää viivettä.

Toinen lähestymistapa on nimeltään datan Bucketing. Tämä antaa analyytikolle mahdollisuuden jakaa tiedot helposti datasolmujen kesken. Kaikilla solmuilla on yhtä suuri määrä dataa jaettuina. Kauhakorkeuspylväs valitaan siten, että siinä on vähiten kardinaalisuutta.

Nämä lähestymistavat eivät ole käytettävissä perinteisessä SQL-menetelmässä.

- TIETOTYYPPI

Perinteisessä lähestymistavassa tuetut tietotyypit ovat hyvin rajallisia. Se tukee vain jäsenneltyä tietoa. Siten itse tietokaavion puhdistaminen ja alustaminen vie enemmän aikaa. Mutta Hadoop tukee monimutkaisia tietotyyppejä, kuten Array, Struct ja Map. Tämä kannustaa käyttämään erityyppistä tietojoukkoa, jota käytetään tietojen lataamiseen. Esimerkille: XML-tiedot voidaan ladata määrittelemällä tiedot XML-elementeillä, jotka sisältävät monimutkaista tietotyyppiä.

- TIETOJEN PARASTAMINEN

Perinteiseen tietokantajärjestelmään on saatavana hyvin vähemmän sisäänrakennettuja pakkaustekniikoita. Mutta Hadoop-kehyksessä on monia pakkaustekniikoita, kuten gzib, bzip2, LZO ja snappy. Oletuspakkaustila on LZ4. Jopa pöydät voidaan pakata käyttämällä pakkaustekniikoita, kuten Parquet, ORC. Pakkaustekniikat auttavat taulukoita käyttämään hyvin vähemmän tilaa, mikä lisää läpäisykykyä ja nopeuttaa kyselyn suorittamista.

Hadoop Vs SQL -vertailutaulukko

| Ominaisuudet | Perinteinen SQL | Hadoop |

| Tiedon koko | gigatavua | petabytes |

| Pääsy | Interaktiivinen & erä | erä |

| päivitykset | Lue ja kirjoita - useita kertoja | Kirjoita kerran, lue useita kertoja |

| Rakenne | Staattinen kaavio | Dynaaminen kaavio |

| eheys | Korkea | Matala |

| skaalaus | Epälineaarinen | Lineaarinen |

Taulukko : Vertailu perinteisen Hadoopin ja SQL-kehyksen välillä.

Johtopäätös - Hadoop Vs SQL

Kaiken kaikkiaan Hadoop etenee perinteisen SQL: n edessä kustannusten, ajan, suorituskyvyn, luotettavuuden, tuettavuuden ja tietojen saatavuuden suhteen erittäin suurelle käyttäjäryhmälle. Hadoop-kehys auttaa hallitsemaan päivittäin tuotettavan valtavan määrän dataa tehokkaasti, joten sieppataan, tallennetaan, prosessoidaan, suodatetaan ja lopulta tallennetaan keskitetyssä paikassa.

Suositeltava artikkeli

- Hadoop vs. pesää - selvitä parhaat erot

- Opi 10 hyödyllistä eroa Hadoop vs Redshift -sovelluksen välillä

- HADOOP vs. RDBMS | Tunne 12 hyödyllistä eroa

- Apache Hadoop vs Apache Spark | 10 parasta vertailua, jotka sinun on tiedettävä!

- Hadoop vs Spark: Ominaisuudet