Johdanto ytimen menetelmiin koneoppimisessa

Kuvioanalyysiin käytetty algoritmi on nimeltään ytimen menetelmä koneoppimisessa. Yleisesti ottaen analyysi tehdään suhteiden löytämiseksi tietojoukoista. Nämä suhteet voivat olla klusterointia, luokittelua, pääkomponentteja, korrelaatiota jne. Suurin osa näistä algoritmeista, jotka ratkaisevat nämä kuvion analysointitehtävät, Tarvitsevatko tiedot raa'ina edustavina, muutetaan nimenomaisesti piirrevektoriesityksenä. Tämä muunnos voidaan suorittaa käyttäjän määrittelemällä ominaisuuskartalla. Joten voidaan olettaa, että ytimen menetelmä vaatii vain käyttäjän määrittelemän ytimen.

Terminaali Kernal-menetelmä tulee siitä, että he käyttävät ytimen toimintoa, jonka avulla he voivat suorittaa operaation korkean ulottuvuuden, implisiittisessä ominaisuustilassa ilman, että tarvitsee laskea kyseisen tilan tietojen koordinaatteja. Sen sijaan ne yksinkertaisesti laskevat sisäisen tuotteen kaikkien ominaisuusalueella olevien paripaikkojen kuvien välillä.

Tällaiset toiminnot ovat laskennallisesti halvempia suurimman osan ajasta verrattuna koordinaattien nimenomaiseen laskentaan. Tätä tekniikkaa kutsutaan "ytimen temppuksi". Mikä tahansa lineaarinen malli voidaan muuntaa epälineaariseksi malliksi soveltamalla ydinvinkki malliin.

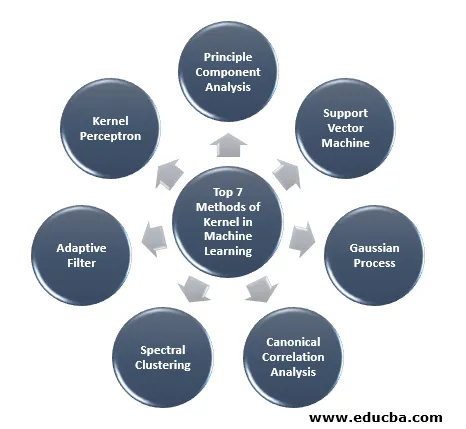

Koneoppimisessa saatavana oleva ytimen menetelmä on pääkomponenttianalyysi (PCA), spektrin ryhmittely, tukivektorikoneet (SVM), kanoninen korrelaatioanalyysi, ytimen perceptron, Gaussin prosessit, harjanteen regressio, lineaariset adaptiiviset suodattimet ja monet muut. Otetaan korkeatasoinen käsitys muutamasta näistä ytimen menetelmistä.

7 ydinmenetelmää koneoppimisessa

Tässä on alla mainitut ytimen menetelmät koneoppimisessa:

1. Periaatekomponenttianalyysi

Pääkomponenttianalyysi (PCA) on tekniikka rakenteen erottamiseksi mahdollisesti korkean ulottuvuuden tietojoukoista. Se suoritetaan helposti käyttämällä iteratiivisia algoritmeja, jotka arvioivat pääkomponentit, tai ratkaisemalla omaarvo-ongelma. PCA on ortogonaalinen muunnos koordinaattijärjestelmästä, jossa kuvaamme tietomme. Uusi koordinaattijärjestelmä saadaan projisoimalla datan pääakselille. Pieni määrä pääkomponentteja riittää usein ottamaan huomioon suurimman osan tietojen rakenteesta. Yksi sen pääsovelluksista on tehdä tutkittavaa data-analyysiä ennustavan mallin valmistamiseksi. Sitä käytettiin useimmiten visualisoimaan populaatioiden ja geneettisen etäisyyden suhteet.

2. Tuki Vector Machine

SVM voidaan määritellä luokittelijaksi erottamaan hypertaso, jossa hyper Taso on yhden ulottuvuuden alatila, joka on pienempi kuin ympäröivä tila. Tämän matemaattisen tilan ulottuvuus määritellään koordinaattien vähimmäismääräksi, joka tarvitaan minkä tahansa pisteen määrittämiseen, kun taas ympäröivä tila on matemaattisen kohteen ympäröivä tila. Nyt matemaattisella esineellä voidaan ymmärtää abstrakti esine, jota ei ole missään vaiheessa tai paikassa, mutta joka esiintyy tyyppisenä asiana.

3. Gaussin prosessi

Gaussin prosessi nimettiin Cark Friedrich Gaussin mukaan, koska siinä käytetään Gaussin jakauman (normaalijakauma) merkintää. Se on stokastinen prosessi, joka tarkoittaa kokoelmaa satunnaismuuttujia, jotka on indeksoitu ajan tai tilan mukaan. Gaussin prosessissa satunnaismuuttujilla on monimuuttuja normaalijakauma, ts. Kaikki sen äärelliset lineaariset yhdistelmät jakautuvat normaalisti. Gaussin prosessi käyttää normaalijakaumasta perittyjä ominaisuuksia, ja siksi ne ovat hyödyllisiä tilastollisessa mallinnuksessa. Koneoppimisalgoritmissa, joka sisältää tämän ytimen menetelmän, käytetään laiskojen oppimisen mittaa ja pisteiden välistä samankaltaisuutta ennustamaan näkymättömien pisteiden arvo harjoitustiedoista. Tämä ennuste ei ole vain arvio, vaan epävarmuus tuolloin.

4. Kanoninen korrelaatioanalyysi

Kanoninen korrelaatioanalyysi on tapa päätellä tietoa kovarianssimatriiseista. Se tunnetaan myös nimellä kanoninen muuttujien analyysi. Oletetaan, että meillä on kaksi vektoria X, Y satunnaismuuttujaa, sanotaan kaksi vektoria X = (X1, …, Xn) ja vektori Y = (Y1, …, Ym), ja muuttujalla on korrelaatio, sitten CCA laskee lineaarisen yhdistelmän X: stä. ja Y, jolla on maksimikorrelaatio keskenään.

5. Spektrin ryhmittely

Kuvan segmentoinnin sovelluksessa spektrin ryhmittelyä kutsutaan segmentointiperusteiseksi objektiluokitteluksi. Spektriklusteroinnissa mittasuhteiden pienentäminen suoritetaan ennen klusterointia vähemmässä ulottuvuudessa, tämä tehdään käyttämällä datan samankaltaisuusmatriisin omaarvoa. Sen juuret ovat graafiteoriassa, jossa tätä lähestymistapaa käytetään solmuyhteisöjen tunnistamiseen kuvaajassa, joka perustuu niitä yhdistäviin reunoihin. Tämä menetelmä on riittävän joustava ja antaa meille mahdollisuuden ryhmitellä tietoja myös kuvaajasta.

6. Adaptiivinen suodatin

Adaptiivinen suodatin käyttää lineaarista suodatinta, joka käsittää siirtofunktion, jota ohjataan muuttuvilla parametreilla, ja menetelmät, joita käytetään näiden parametrien säätämiseen optimointialgoritmin mukaisesti. Tämän optimointialgoritmin monimutkaisuus on syy siihen, että kaikki adaptiiviset suodattimet ovat digitaalisia suodattimia. Mukautuvaa suodatinta tarvitaan sovelluksissa, joissa ei ole etukäteen tietoa halutusta käsittelytoiminnosta etukäteen tai ne muuttuvat.

Kustannustoimintoa käytetään suljetussa silmukassa mukautuvassa suodattimessa, koska se on tarpeen suodattimen optimaalisen toiminnan kannalta. Se määrittelee kuinka muokata suodattimen siirtofunktiota seuraavan iteroinnin kustannusten vähentämiseksi. Yksi yleisimmistä toiminnoista on virhesignaalin keskimääräinen neliövirhe.

7. Ydin Perceptron

Koneoppimisessa ytimen perceptron on eräänlainen suosittu perceptron-oppimisalgoritmi, joka voi oppia ytimen koneita, kuten epälineaariset luokittelijat, jotka käyttävät ytintoimintoa laskeakseen niiden näytteiden samankaltaisuuden, joita ei ole nähty koulutusnäytteisiin. Tämä algoritmi keksittiin vuonna 1964 ja teki siitä ensimmäisen ytimen luokittelun oppijan.

Suurin osa tarkastelluista ytimen algoritmeista perustuu kuperaan optimointiin tai ominaisongelmiin ja ovat tilastollisesti perusteltuja. Niiden tilastolliset ominaisuudet analysoidaan tilastollisen oppimisteorian avulla.

Ydinmenetelmien sovellusalueista puhuttaessa se on monipuolinen ja sisältää geostatistiikan, krigingin, käänteisen etäisyyspainotuksen, 3D-rekonstruoinnin, bioinformatiikan, kemoinformatiikan, tiedonkeruun ja käsialan tunnistuksen.

johtopäätös

Olen tiivistänyt joitain koneoppimisessa käytettäviä ydinmenetelmien termejä ja tyyppejä. Tilapuutteen vuoksi tämä artikkeli ei missään nimessä ole kattava, ja sen tarkoituksena on vain antaa ymmärrys ytimen menetelmästä ja lyhyt yhteenveto niiden tyypeistä. Tämän artikkelin kattaminen saa sinut kuitenkin ottamaan ensimmäisen askeleen koneoppimisen alalla.

Suositellut artikkelit

Tämä on opas ydinmenetelmään koneoppimisessa. Tässä keskustellaan seitsemästä ydinmenetelmätyypistä koneoppimisessa. Voit myös tarkastella seuraavaa artikkelia.

- Monoliittinen ydin

- Klusterointi koneoppimisessa

- Data Science Machine Learning

- Valvomaton koneoppiminen

- PHP-suodattimet | Kuinka vahvistaa käyttäjän syöttämät tiedot eri suodattimilla?

- Täydellinen opas koneoppimisesta