Johdanto yksinkertaiseen lineaariseen regressioon

Sanakirjasta : Paluu entiseen tai vähemmän kehittyneeseen tilaan.

Tilastoissa: Yhden muuttujan keskiarvon ja muiden muuttujien vastaavien arvojen välisen suhteen mitta.

Regressiota, jossa tulomuuttujan (riippumaton muuttuja) ja kohdemuuttujan (riippuvainen muuttuja) välistä suhdetta pidetään lineaarisena, kutsutaan lineaariseksi regressioksi. Yksinkertainen lineaarinen regressio on tyyppi lineaarista regressiota, jossa meillä on vain yksi riippumaton muuttuja ennustamaan riippuvainen muuttuja. Yksinkertainen lineaarinen regressio on yksi koneoppimisalgoritmeista. Yksinkertainen lineaarinen regressio kuuluu ohjatun oppimisen perheeseen. Regressiota käytetään jatkuvien arvojen ennustamiseen.

Yksinkertaisen lineaarisen regression malli

Tehdään siitä yksinkertainen. Miten kaikki alkoi?

Kaikki alkoi vuonna 1800 Francis Galtonilla. Hän tutki isien ja heidän poikiensa pituussuhdetta. Hän havaitsi kuvion: Kummankin pojan pituus olisi yhtä pitkä, koska isänsä tai pojan pituus on taipumus olla lähempänä kaikkien ihmisten keskimääräistä keskikorkeutta. Tämä ilmiö on vain regressiota.

Esimerkiksi Shaq O'Neal on erittäin kuuluisa NBA-pelaaja ja on 2, 16 metriä pitkä. Hänen poikansa Shaqir ja Shareef O'neal ovat vastaavasti 1, 96 metriä ja 2, 06 metriä korkeita. Väkiluku on keskimäärin 1, 76 metriä. Pojan korkeuden regressi (ajautuminen kohti) keskikorkeuden.

Kuinka suuntaamme?

Lasketaan regression vain kahdella datapisteellä:

Ainoa mitä haluamme tehdä parhaan regression löytämiseksi, on vetää viiva, joka on mahdollisimman lähellä jokaista pistettä. Kahden datapisteen tapauksessa on helppo vetää viiva, liity vain niihin.

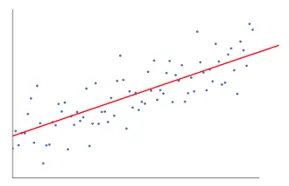

Jos meillä on nyt useita datapisteitä, kuinka vetää viiva, joka on mahdollisimman lähellä kutakin tietopistettä.

Tässä tapauksessa tavoitteemme on minimoida linjan ja kaikkien datapisteiden välinen pystysuuntainen etäisyys. Tällä tavalla ennustamme parhaan viivan Lineaariselle regressiomallillemme.

Mikä yksinkertainen lineaarinen regressio on?

Alla on yksityiskohtainen selitys yksinkertaisesta lineaarisesta regressiosta:

- Se piirtää paljon ja paljon mahdollisia rivejä ja tekee sitten minkä tahansa tämän analyysin.

- Neliövirheiden summa.

- Absoluuttisten virheiden summa.

- pienimmän neliön menetelmä … jne

- Käytämme analyysissamme vähiten neliömetodia.

- Teemme ero kaikkien pisteiden välillä ja laskemme kaikkien pisteiden summan neliön. Kumpi linja antaa vähimmäissumman, on paras rivimme.

Esimerkki: Näin tekemällä voimme ottaa useita miehiä ja heidän poikansa pituuden ja tehdä esimerkiksi kertoa miehelle, kuinka pitkä hänen poikansa voi olla. ennen kuin hän edes syntyi.

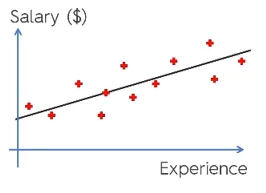

Google Kuva

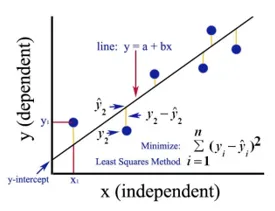

Yllä oleva kuva osoittaa yksinkertaisen lineaarisen regression. Rivi edustaa regressioviivaa. Antaa: y = a + b * x

Missä y on riippuvainen muuttuja (DV): Esimerkiksi kuinka henkilön palkka muuttuu työntekijän kokemusvuosien mukaan. Joten tässä työntekijän tai henkilön palkka on riippuvainen muuttujasi.

Riippuvainen muuttuja on tavoitemuuttujamme, sen, jonka haluamme ennustaa käyttämällä lineaarista regressiota.

x on itsenäinen muuttujamme (IV): Riippuvainen muuttuja on syy muutokseen riippumattomaan muuttujaan. Yllä olevassa esimerkissä kokemusten lukumäärä on riippuvainen muuttujamme, koska kokemusten lukumäärä aiheuttaa muutoksen työntekijän palkkaan.

- b on kertoimen muuttuja riippumattomalle muuttujalle x. Tällä kertoimella on tärkeä rooli. Se kertoo kuinka yksikön muutos x (IV) tulee vaikuttamaan y (DV). Sitä kutsutaan myös suhteellisuuskerroimeksi. Matematiikan kannalta on sinun vastuullasi viivan kaltevuus tai voit sanoa viivan jyrkkä.

- Esimerkissämme, jos kaltevuus (b) on pienempi, mikä tarkoittaa sitä, että vuosien lukumäärä tuottaa vähemmän palkkaa, toisaalta jos kaltevuus (b) on suurempi, palkka nousee voimakkaasti lisääntymällä vuosien kokemus.

- a on vakioarvo. Sitä kutsutaan myös sieppaukseksi, jolloin linja leikkaa y-akselin tai DV-akselin. Toisella tavalla voidaan sanoa, että kun työntekijällä on nollan vuoden kokemus (x), palkka (y) työntekijälle on vakio (a).

Kuinka Least Square toimii?

Alla on pienimmän neliösumman pisteet:

- Se piirtää mielivaltaisen viivan datan kehityksen mukaan.

- Se vie datapisteitä ja piirtää pystysuoria viivoja. Se pitää vertikaalista etäisyyttä parametrina.

- Nämä pystysuorat viivat leikkaavat regressioviivan ja antavat vastaavan pisteen datapisteille.

- Sitten se löytää vertikaalisen eron kunkin datapisteen ja sitä vastaavan datapisteen välillä regressioviivalla.

- Se laskee virheen, joka on erotuksen neliö.

- Sitten se laskee virheiden summan.

- Sitten se taas vetää viivan ja toistaa yllä mainitun toimenpiteen vielä kerran.

- Se vetää useita viivoja tällä tavalla ja rivi, joka antaa vähiten virhesummaa, valitaan parhaaksi riviksi.

- Tämä paras linja on yksinkertainen lineaarinen regressiolinja.

Yksinkertaisen lineaarisen regression soveltaminen

Regressioanalyysi suoritetaan jatkuvan muuttujan ennustamiseksi. Regressioanalyysillä on laaja valikoima sovelluksia. Joitakin esimerkkejä ovat seuraavat:

- Ennustava analyysi

- Markkinoinnin tehokkuus,

- hinnoittelu kaikista listoista

- tuotteen mainosennuste.

Tässä keskustellaan yhdestä lineaarisen regression sovelluksesta ennustavaan analytiikkaan. Suoritamme mallinnuksen pythonilla.

Vaiheet, joita aiomme seurata mallimme rakentamiseksi, ovat seuraavat:

- Tuomme kirjastot ja tietoaineistot.

- Käsittelemme tiedot esikäsittelyn.

- Jaamme tiedot koejoukkoon ja harjoitusjoukkoon.

- Luomme mallin, joka yrittää ennustaa tavoitemuuttujan koulutusjoukkojemme perusteella

- Ennustamme tavoitemuuttujan testijoukolle.

- Analysoimme mallin ennustamia tuloksia

Käytämme analyysissamme palkka-aineistoa, jossa on 30 työntekijää.

# Kirjastot tuodaan

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

# Tietojoukon tuominen (näyte näytetään taulukossa)

dataset = pd.read_csv('Salary_Data.csv')

| vuosien kokemus | palkkaus |

| 1, 5 | 37731 |

| 1.1 | 39343 |

| 2.2 | 39891 |

| 2 | 43525 |

| 1.3 | 46205 |

| 3.2 | 54445 |

| 4 | 55749 |

# Esikäsitellä tietojoukko, jaamme tässä tietojoukon riippuvaiseen muuttujaan ja riippumattomaan muuttujaan. x riippumattomana ja y riippuvaisena tai kohdemuuttujana

X = dataset.iloc(:, :-1).values

y = dataset.iloc(:, 1).values

# Jakamalla tietojoukko Harjoittelu- ja Testisarjaan:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 1/3, random_state = 0)

Testikoko 1/3 osoittaa, että kokonaistiedoista 2/3 on osa mallin kouluttamista ja loput 1/3 käytetään mallin testaamiseen.

# Sovitaan yksinkertainen lineaarinen regressiomalli harjoitusjoukkoon

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, y_train)

Lineaarinen regressiomalli on nyt koulutettu. Tätä mallia käytetään ennustamaan riippuvainen muuttuja.

# Testisarjan tulosten ennustaminen

y_pred = regressor.predict(X_test)

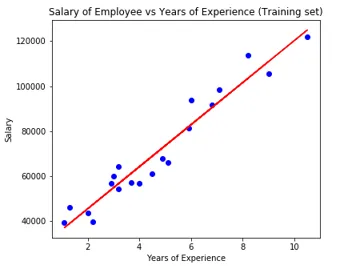

# Testijoukon tulosten visualisointi

plt.scatter(X_test, y_test, color = 'blue')

plt.plot(X_train, regressor.predict(X_train), color = 'red')

plt.title('Salary of Employee vs Experience (Test set)')

plt.xlabel('Years of Experience')

plt.ylabel('Salary')

plt.show()

# Mallin parametri

print(regressor.intercept_)

print(regressor.coef_)

26816.19224403119

(9345.94244312)

Joten sieppaimen (a) arvo on 26816. Mikä viittaa siihen, että mikä tahansa tuoreempi (nollakokemus) saisi noin 26816 palkan.

Kerroin mallillemme tuli 9345.94. Se ehdottaa, että pitämällä kaikki muut parametrit vakiona, muutos yhdessä riippumattoman muuttujan yksikössä (vuosia ilmaistuna) tuottaa 9345 yksikön palkan muutoksen.

Regression arviointitiedot

Regressioanalyysille on saatavana periaatteessa 3 tärkeää arviointimittaustapaa:

- Keskimääräinen absoluuttinen virhe (MAE): Se näyttää absoluuttisten virheiden keskiarvon, joka on ero ennustetun ja todellisen välillä.

- Keskimääräinen neliövirhe (MSE): Se näyttää neliövirheiden keskiarvon.

- Juuren keskimääräinen neliövirhe (RMSE): Se näyttää neliöjuurien keskiarvon neliöjuuren.

Voimme verrata yllä olevia menetelmiä:

- MAE: Se näyttää keskimääräisen virheen ja helpoimman kaikista kolmesta menetelmästä.

- MSE: Tämä on suositumpi kuin MAE, koska se parantaa suurempia virheitä, mikä johtaa enemmän oivalluksia.

- RMSE: Tämä on parempi kuin MSE, koska voimme tulkita virheen y-muodossa.

Nämä 3 eivät ole mitään muuta kuin häviötoiminnot.

# Mallin arviointi

from sklearn import metrics

print('MAE:', metrics.mean_absolute_error(y_test, y_pred))

print('MSE:', metrics.mean_squared_error(y_test, y_pred))

print('RMSE:', np.sqrt(metrics.mean_squared_error(y_test, y_pred)))

MAE: 3426.4269374307123

MSE: 21026037.329511296

RMSE: 4585.4157204675885

johtopäätös

Lineaarinen regressioanalyysi on tehokas työkalu koneoppimisalgoritmeille, jota käytetään ennustamaan jatkuvia muuttujia, kuten palkka, myynti, suorituskyky jne. Lineaarisella regressiolla tarkastellaan lineaarista suhdetta riippumattomien ja riippuvien muuttujien välillä. Yksinkertaisella lineaarisella regressiolla on vain yksi riippumaton muuttuja, jonka perusteella malli ennustaa kohdemuuttujan. Olemme keskustelleet lineaarisen regression mallista ja soveltamisesta ennusteanalyysin avulla työntekijöiden palkan ennustamiseksi.

Suositellut artikkelit

Tämä on opas yksinkertaiseen lineaariseen regressioon. Tässä keskustellaan lineaarisen regression mallista ja soveltamisesta käyttämällä ennustavaa analyysiesimerkkiä työntekijöiden palkkojen ennustamiseen. Voit myös käydä läpi muiden aiheeseen liittyvien artikkeleidemme saadaksesi lisätietoja-

- Lineaarinen regressioanalyysi

- Lineaarinen regressio R: ssä

- Lineaarisen regression mallintaminen

- Regressiotestityökalut

- Matplotlib Pythonissa | Matplotlibin 14 parasta tonttia

- Sanakirja Pythonissa Menetelmät ja esimerkit

- Esimerkkejä PHP: n neliöjuurista

- Lineaarinen regressio vs. logistinen regressio | Suurimmat erot