Johdanto koneoppimismenetelmiin

Seuraava artikkeli, koneoppimismenetelmät, antaa yleiskuvan koneoppimisessa yleisimmin käytetyistä menetelmistä. Koneoppiminen on tekniikka, jonka avulla tietokone pystyy "oppimaan" asioita yksinään. Algoritmit parantavat adaptiivisesti suorituskykyään, kun oppimiseen käytettävää tietoa kasvaa. Eli mitä enemmän tietoja, sitä tarkempi mallisi olisi.

Kuinka koneet oppivat?

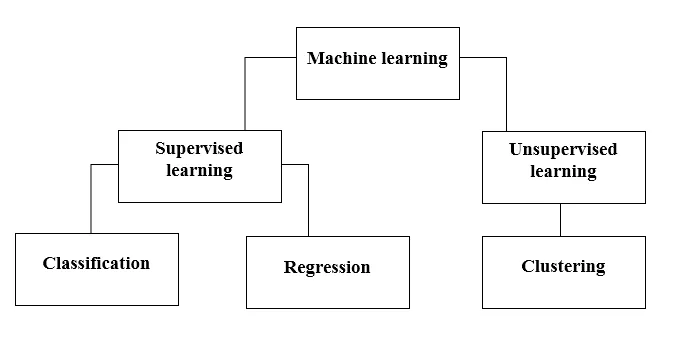

Tätä varten on olemassa useita menetelmiä. Mikä menetelmä noudatetaan täysin, riippuu ongelmalausunnosta. Aineistosta ja ongelmastamme riippuen on kaksi erilaista tapaa syventää. Yksi on ohjattu oppiminen ja toinen on ohjaamaton oppiminen. Seuraava taulukko selittää koneoppimismenetelmien lisäluokituksen. Keskustelemme niistä yksi kerrallaan.

Katso seuraava kaavio!

Ymmärretään, mitä ohjattu oppiminen tarkoittaa.

Ohjattu oppiminen

Kuten nimestä voi päätellä, kuvittele opettaja tai esimies, joka auttaa sinua oppimaan. Sama pätee koneisiin. Harjoitamme tai opetamme konetta merkittyjen tietojen avulla.

Jotkut tyylikkäimmistä ohjatuista oppimissovelluksista ovat:

- Sentiment-analyysi (Twitter, Facebook, Netflix, YouTube jne.)

- Luonnollinen kielenkäsittely

- Kuvien luokittelu

- Ennustava analyysi

- Hahmontunnistus

- Roskapostin havaitseminen

- Puheen / sekvenssin käsittely

Nyt valvottu oppiminen on edelleen jaettu luokitukseen ja regressioon. Ymmärretään tämä.

Luokittelu

Luokittelu on prosessi, jolla löydetään malli, joka auttaa erottamaan tiedot eri luokkiluokkiin. Tässä prosessissa data luokitellaan eri tunnisteisiin joidenkin syöttössä annettujen parametrien perusteella ja sitten ennustetaan tiedoille tarrat. Kategorinen tarkoittaa, että tulostemuuttuja on luokka, eli punainen tai musta, roskapostia tai ei roskapostia, diabeetikko tai ei-diabeetikko jne.

Luokittelumalleja ovat tukivektorikone (SVM), K-lähin naapuri (KNN), Naive Bayes jne.

a) Tukivektorikoneiden luokittelu (SVM)

SVM on ohjattu oppimismenetelmä, joka tarkastelee tietoja ja lajittelee ne kahteen luokkaan. Käytän tietojen luokittelua hyperkoneella. Lineaarinen syrjivä luokitteluyritys yrittää piirtää suoran erottaen kaksi tietojoukkoa ja siten luoda mallin luokitukselle. Se yksinkertaisesti yrittää löytää viivan tai käyrän (kahdessa ulottuvuudessa) tai jakoputken (useita ulottuvuuksia), joka jakaa luokat toisistaan.

Huomaa - moniluokkaisessa luokituksessa SVM käyttää 'yksi vs. loput', mikä tarkoittaa eri SVM: n laskemista kullekin luokalle.

b) K-lähimmän naapurin luokitin (KNN)

- Jos luet huolellisesti, nimi itse viittaa siihen, mitä algoritmi tekee. KNN katsoo, että lähempät tietopisteet ovat ominaisuuksien suhteen paljon samankaltaisia ja kuuluvat siten todennäköisemmin samaan luokkaan kuin naapuri. Jokaiselle uudelle datapisteelle lasketaan etäisyys muihin tietopisteisiin ja luokka päätetään K lähimpien naapureiden perusteella. Kyllä, se voi kuulostaa ontkalta, mutta joillekin luokituksista se toimii kuin mikä tahansa.

- Datapiste luokitellaan naapureidensa enimmäismäärällä, sitten datapiste osoitetaan luokalle, joka on lähinnä k-naapureidensa keskuudessa.

- KNN: ssä mallin oppimista ei vaadita, ja kaikki työ tapahtuu ennustetta pyydettäessä. Siksi KNN: ää kutsutaan usein laiskaksi oppimisalgoritmiksi.

c) Naiivi Bayes -luokittelija

- Naiivi Bayes on koneoppimisalgoritmi, jota suositellaan erittäin hyvin tekstin luokitteluongelmiin. Se perustuu Bayesin todennäköisyyslauseeseen. Näitä luokittelijoita kutsutaan naiiviksi, koska ne olettavat, että ominaisuusmuuttujat ovat toisistaan riippumattomia. Tämä tarkoittaa esimerkiksi, että meillä on täysi lause syöttämistä varten, niin Naive Bayes olettaa, että jokainen lause lauseessa on riippumaton muista. Ja luokittele sitten ne vastaavasti. Tiedän, se näyttää melko naiivilta, mutta se on loistava valinta tekstien luokitteluongelmiin ja suosittu valinta roskapostin luokitteluun.

- Se tarjoaa erityyppisiä Naive Bayes -algoritmeja, kuten BernoulliNB, GaussianNB, MultinomialNB.

- Se katsoo, että kaikki piirteet eivät liity toisiinsa, joten se ei voi oppia ominaisuuksien välistä suhdetta. Oletetaan esimerkiksi, että Varun haluaa syödä hampurilaisia, hän myös syö ranskalaisia perunoita koksilla. Mutta hän ei halua syödä hampurilaista ja ranskalaisten perunoiden yhdistelmää koksin kanssa. Täällä Naiivi Bayes ei voi oppia kahden piirteen välistä suhdetta, vaan oppii vain yksittäisten piirteiden tärkeyden.

Siirrytään nyt valvotun oppimismenetelmämme toiselle puolelle, joka on regressio.

Regressio

Regressio on prosessi, jolla löydetään malli, joka auttaa erottamaan tiedot jatkuvien arvojen avulla. Tässä järjestetään ennustetun datan luonne. Joitakin yleisimmin käytettyjä regressiomalleja ovat lineaarinen regressio, satunnainen metsä (päätöspuut), hermostoverkot.

Lineaarinen regressio

- Yksi yksinkertaisimmista lähestymistavoista ohjatussa oppimisessa, josta on hyötyä kvantitatiivisen vasteen ennustamisessa.

- Lineaarinen regressio sisältää parhaiten sopivan suoran löytämisen pisteiden läpi. Parhaiten sopivaa linjaa kutsutaan regressioviivaksi. Paras istuvuusviiva ei kulje tarkalleen kaikkien datapisteiden läpi, vaan yrittää sen sijaan päästä lähelle niitä.

- Se on laajalti käytetty algoritmi jatkuvalle tiedolle. Se keskittyy kuitenkin vain riippuvaisen muuttujan keskiarvoon ja rajoittuu lineaariseen suhteeseen.

- Lineaarista regressiota voidaan käyttää aikasarjojen, trendien ennustamiseen. Se voi ennustaa tulevan myynnin aiempien tietojen perusteella.

Ohjaamaton oppiminen

- Ohjaamaton oppiminen perustuu lähestymistapaan, jonka voidaan ajatella olevan opettajan poissaolo ja siten absoluuttinen virhemitta. Se on hyödyllistä, kun se vaatii opiskelua klusteroinnin tai elementtien ryhmittelyn. Elementit voidaan ryhmitellä (ryhmitellä) niiden samankaltaisuuden perusteella.

- Valvomattomassa oppimisessa tietoja ei merkitä, niitä ei luokitella ja järjestelmän algoritmit toimivat tietoihin ilman ennakkoharjoittelua. Valvomattomat oppimisalgoritmit voivat suorittaa monimutkaisempia tehtäviä kuin ohjatut oppimisalgoritmit.

- Valvomaton oppiminen sisältää klusteroinnin, joka voidaan tehdä käyttämällä K-ryhmän klusterointia, hierarkkista, Gaussin sekoitusta, piilotettua Markovin mallia.

Valvomattomia oppimissovelluksia ovat:

- Samankaltaisuuden havaitseminen

- Automaattinen merkinnät

- Objektien segmentointi (kuten henkilö, eläin, elokuvat)

klustereiden

- Klusterointi on valvomaton oppimistekniikka, jota käytetään data-analytiikkaan monilla aloilla. Rypytysalgoritmi on kätevä, kun haluamme saada yksityiskohtaista tietoa tiedoistamme.

- Oikea esimerkki klusteroinnista olisi Netflixin genreklustereita, jotka on jaettu eri kohdeasiakkaille mukaan lukien kiinnostuksen kohteet, väestötiedot, elämäntavat jne. Nyt voit miettiä kuinka hyödyllinen klusterointi on, kun yritykset haluavat ymmärtää asiakaspohjaaan ja kohdistaa uutta potentiaalia. Asiakkaat.

a) K tarkoittaa klusterointia

- K tarkoittaa klusterointialgoritmia, joka yrittää jakaa annetun tuntemattoman datan klusteriin. Se valitsee satunnaisesti 'k' klustereiden keskikohdan, laskee etäisyyden datapisteiden ja klustereiden keskipisteen välillä ja osoittaa lopulta datapisteen klusterin keskipisteelle, jonka etäisyys on pienin kaikista klusterin keskipisteistä.

- K-keskiarvoissa ryhmät määritellään kunkin ryhmän lähimmän keskipisteen perusteella. Tämä centroidi toimii algoritmin 'aivona', he hankkivat heille lähimmät datapisteet ja lisäävät sitten klusteriin.

b) Hierarkkinen ryhmittely

Hierarkkinen klusterointi on melkein samanlainen kuin normaalissa klusteroinnissa, ellet halua luoda klusterien hierarkiaa. Tästä voi olla hyötyä, kun haluat päättää klusterien määrän. Oletetaan esimerkiksi, että luot ryhmiä eri tavaroita verkkokaupassa. Etusivulta haluat muutaman laajan kohteen ja kun napsautat yhtä kohdetta, tiettyjä luokkia, se on tarkempia klustereita, avautuu.

Mitat pieneneminen

Mitat pienentämistä voidaan pitää tiedoston pakkaamisena. Se tarkoittaa, että otetaan pois tiedot, joilla ei ole merkitystä. Se vähentää tietojen monimutkaisuutta ja yrittää pitää merkitykselliset tiedot. Esimerkiksi kuvan pakkaamisessa vähennämme sen tilan ulottuvuutta, jossa kuva pysyy sellaisenaan, tuhoamatta liikaa kuvan merkityksellistä sisältöä.

PCA tietojen visualisointiin

Pääkomponenttianalyysi (PCA) on ulottuvuuden pienentämismenetelmä, joka voi olla hyödyllinen tietojen visualisoinnissa. PCA: ta käytetään pakkaamaan korkeamman ulottuvuuden tiedot alemman ulottuvuuden tietoon, ts. Voimme käyttää PCA: ta pienentämään neliulotteisen tiedon kolmeen tai kahteen ulottuvuuteen, jotta pystymme visualisoimaan ja ymmärtämään paremmin tietoja.

Suositellut artikkelit

Tämä on opas koneoppimismenetelmiin. Täällä olemme keskustelleet johdannosta, kuinka koneet oppivat? koneoppimisluokitukset ja vuokaavio yksityiskohtaisine selityksineen. Voit myös käydä läpi muiden ehdotettujen artikkeleidemme saadaksesi lisätietoja -

- Koneoppimisarkkitehtuuri

- Koneoppiminen

- Konetyökalut

- Koneoppimistekniikat

- Hyperparametrinen koneoppiminen

- Hierarkkinen klusterointialgoritmi

- Hierarkkinen ryhmittely | Agglomeratiivinen ja jakautuva klusterointi